L'histoire de l'IA :de la fiction futuriste à l'avenir de l'entreprise

Dites les mots « intelligence artificielle » et la plupart des gens pensent à Alexa et Siri. D'autres pourraient penser à des films comme Terminator ou 2001 :l'Odyssée de l'espace.

La vérité est que l'intelligence artificielle (IA) n'est pas un concept de science-fiction lointain. En fait, c'est partout autour de nous :pensez à Netflix qui recommande votre prochaine émission de télévision ou à Uber qui optimise le meilleur itinéraire pour rentrer chez vous.

L'IA est un écosystème sophistiqué de technologies modernes et interconnectées qui a évolué au fil des décennies et qui continue d'évoluer aujourd'hui. Il n'est donc pas surprenant que l'histoire de l'IA soit également complexe et multicouche. C'est une histoire qui présente une variété d'outils et de capacités changeants qui ont construit l'IA telle que nous la connaissons jusqu'à son état actuel.

Pour comprendre l'importance de l'IA aujourd'hui et se préparer pour demain, il est utile de comprendre où l'IA a commencé et comment elle a évolué pour devenir la technologie révolutionnaire qu'elle est aujourd'hui.

IA du XXe siècle :une preuve de concept ambitieuse

L'IA moderne est née dans les chambres universitaires des départements de recherche universitaires d'élite, où les universitaires ont profondément réfléchi à l'avenir de l'informatique. Mais ses premières années l'ont laissé confiné dans ces chambres, bloqué par manque de données et de puissance de calcul.

En 1956, le Dartmouth College a accueilli le projet de recherche d'été de Dartmouth sur l'intelligence artificielle, un atelier qui est devenu une première étape cruciale dans la recherche universitaire sur l'IA. Au cours de l'atelier, 20 chercheurs avaient pour objectif de prouver l'hypothèse selon laquelle l'apprentissage pouvait être décrit avec une telle précision "qu'une machine peut être conçue pour le simuler".

Un an plus tard, en 1957, le psychologue américain Frank Rosenblatt a développé la recherche de Dartmouth avec le perceptron, un algorithme capable d'effectuer avec succès une classification binaire. C'est là que nous avons commencé à voir des preuves prometteuses de la façon dont les neurones artificiels pouvaient apprendre des données.

Et une autre année plus tard, John McCarthy, participant au projet de recherche d'été de Dartmouth sur l'intelligence artificielle, et de nombreux étudiants du MIT, ont développé Lisp (un nouveau langage de programmation). Des décennies plus tard, les recherches de McCarthy contribueront à donner vie à de nouveaux projets encore plus passionnants, notamment le programme de langage naturel SHRDLU, le système d'algèbre Macsyma et le système logique ACL2.

Source

En repensant à ces premières expériences, nous pouvons voir l'IA faire ses premiers pas chancelants du monde de la recherche de haut niveau vers le monde pratique de l'informatique.

L'année 1960 a vu les débuts de Simulmatics, une entreprise qui prétendait pouvoir prédire comment les gens voteraient en fonction de leurs données démographiques.

En 1965, des chercheurs ont développé des « systèmes experts ». Ces systèmes ont permis à l'IA de résoudre des problèmes spécialisés au sein des systèmes informatiques en combinant une collection de faits et un moteur d'inférence pour interpréter et évaluer les données.

Puis, un an plus tard, en 1966, le professeur du MIT Joseph Weizenbaum a conçu un programme de correspondance de modèles appelé Eliza qui montrait aux utilisateurs que l'IA était intelligente. Les utilisateurs pourraient donner des informations au programme, et Eliza, agissant en tant que psychothérapeute, leur servirait une question ouverte en réponse.

Au milieu des années 1970, les gouvernements et les entreprises perdaient confiance dans l'IA. Le financement s'est tari et la période qui a suivi est devenue connue sous le nom d '«hiver de l'IA». Bien qu'il y ait eu de petites résurgences dans les années 1980 et 1990, l'IA a été principalement reléguée au domaine de la science-fiction et le terme a été évité par les informaticiens sérieux.

De la fin des années 1990 au début des années 2000, nous avons vu l'application à grande échelle de techniques d'apprentissage automatique telles que les méthodes bayésiennes pour le filtrage du spam par Microsoft et le filtrage collaboratif pour les recommandations d'Amazon.

IA du XXIe siècle :programmes pilotes très réussis

Dans les années 2000, la puissance de calcul, des ensembles de données plus volumineux et l'essor des logiciels open source ont permis aux développeurs de créer des algorithmes avancés qui révolutionneraient les communautés scientifique, de consommation, de fabrication et d'affaires en un temps relativement court. L'IA est aujourd'hui devenue une réalité pour de nombreuses entreprises. McKinsey, par exemple, a trouvé 400 exemples d'entreprises utilisant actuellement l'IA pour résoudre des problèmes commerciaux.

Le Web offre de nouvelles façons d'organiser les données

La révolution Web qui a balayé le monde du début au milieu des années 2000 a laissé le monde de la recherche en IA avec quelques changements importants. Les technologies fondamentales telles que le langage XML (Extensible Markup Language) et le PageRank ont organisé les données de nouvelles façons que l'IA pourrait utiliser.

XML était une condition préalable au Web sémantique et aux moteurs de recherche. PageRank, une des premières innovations de Google, a organisé davantage le Web. Ces avancées ont rendu le Web plus utilisable et rendu de grandes quantités de données plus accessibles à l'IA.

Dans le même temps, les bases de données s'amélioraient pour stocker et récupérer des données, tandis que les développeurs travaillaient sur des langages de programmation fonctionnels qui facilitaient l'exploitation de ces données. Les outils étaient présents pour les chercheurs et les développeurs afin de faire progresser la technologie de l'IA.

Les réseaux de neurones et l'apprentissage en profondeur démontrent le potentiel de l'IA

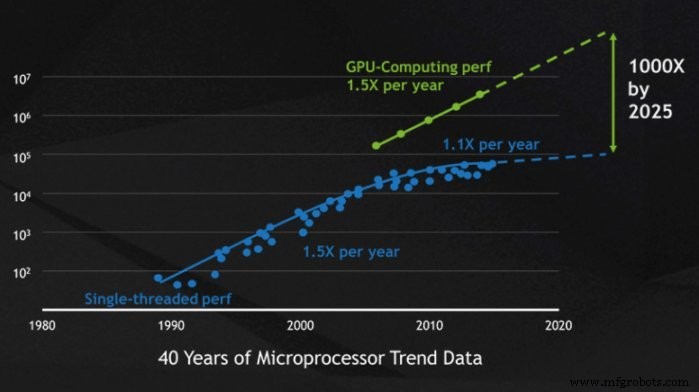

Il y avait de grands rêves pour l'IA au XXe siècle, mais la puissance de calcul les avait rendus presque impossibles à réaliser. Au 21e siècle, cependant, les ordinateurs devenaient exponentiellement plus puissants pour stocker, traiter et analyser de gros volumes de données. Cela signifiait que les nobles objectifs des réseaux de neurones et de l'apprentissage en profondeur pouvaient devenir une réalité.

Les chercheurs ont développé des ensembles de données spécifiquement adaptés à la formation de machines, ce qui a donné lieu à des réseaux de neurones comme AlexNet. Auparavant, la formation des machines reposait sur des ensembles de données qui se comptaient par dizaines de milliers, mais l'avancée des unités de traitement graphique (GPU) signifiait que de nouveaux ensembles de données pouvaient se chiffrer par dizaines de millions.

Le fabricant de puces informatiques Nvidia a lancé sa plate-forme de calcul parallèle, CUDA, en 2006. À l'intérieur de cette plate-forme, Nvidia a utilisé des GPU pour rendre son calcul plus rapide. Cette amélioration des performances a aidé davantage de personnes à exécuter des modèles de machine learning volumineux et complexes écrits dans des bibliothèques de machine learning telles que TensorFlow et PyTorch.

Source

Plus tard, ces bibliothèques deviendraient open source et inspireraient une expérimentation généralisée à mesure que la technologie deviendrait plus accessible. Cette démocratisation de l'IA aiderait de nouveaux outils passionnants comme AlphaGo, Google DeepMind et IBM Deep Blue à démarrer.

La vision par ordinateur ouvre la porte à de nouvelles applications industrielles

Jusque dans les années 2000, l'IA n'était vraiment utile que si vous traitiez du texte. Mais au tournant du siècle, les progrès de la vision par ordinateur, qui permettaient aux ordinateurs de reconnaître et d'interpréter des images, ont poussé les cas d'utilisation de l'IA vers de nouveaux sommets.

Cette fois, nos pionniers n'étaient pas des universitaires. Au lieu de cela, ils vivaient à l'intérieur de votre maison et ont rendu le nettoyage (le Roomba) et les jeux (la XBox Kinect) plus faciles que jamais et ont mis la vision par ordinateur dans les foyers du monde entier.

Nous avons également vu la vision par ordinateur utilisée dans les nouvelles voitures autonomes et dans les hôpitaux pour détecter automatiquement des conditions telles que les lésions et la pneumonie.

Au-delà des cas d'utilisation spécifiques à l'industrie, la variation de la vision par ordinateur a également contribué à l'avancement de l'automatisation des processus robotiques (RPA). 🎉 Complétés par la reconnaissance optique de caractères (OCR), les robots RPA peuvent traiter à la fois des données structurées et non structurées, ce qui a changé le monde de l'analyse de données tel que nous le connaissons.

L'analyse des données améliore les applications métier de l'IA

Les deux dernières décennies nous ont montré que l'automatisation et l'IA peuvent se mesurer à des cas d'utilisation métier complexes. Et au fur et à mesure que l'IA s'améliore dans l'analyse des données, les entreprises peuvent exploiter encore plus l'IA pour les aider à travailler plus intelligemment et plus efficacement.

Les banques utilisent l'IA pour classer les requêtes des clients en différentes catégories à partir d'un grand volume d'e-mails non structurés reçus chaque année. Ce processus est manuel ou génère des résultats médiocres lors de l'utilisation d'une classification de mots clés basée sur des règles. L'IA permet aux banques de classer ces e-mails avec un haut niveau de précision et de réduire le temps de traitement moyen (AHT).

L'IA et l'automatisation n'aident pas seulement les entreprises de services financiers. Les payeurs de soins de santé accélèrent l'identification des grossesses à haut risque. Le robot logiciel charge les données vérifiées du patient et accède à un modèle prédictif pour évaluer les risques du patient, détermine le plan de gestion des soins approprié. Les résultats sont une augmentation de 24 % du nombre de grossesses de faible poids à la naissance qui ont été identifiées avec précision tout en évitant 44 % des grossesses de faible poids à la naissance, ce qui représente une économie totale de 11 millions de dollars par an. Lire l'histoire complète.

Le traitement du langage naturel et la reconnaissance vocale améliorent la convivialité de l'IA

Bien que l'IA ait commencé par l'analyse de texte, elle ne l'a en aucun cas maîtrisé. Jusqu'à récemment, le texte, même avec l'OCR, devait être structuré dans des formats lisibles par machine. Le domaine du traitement du langage naturel (TLN) a mis à l'avant-garde la capacité de programmer des ordinateurs pour comprendre le langage naturel.

L'un des exemples les plus connus de NLP est Generative Pre-trained Transformer 3 (mieux connu sous le nom de GPT-3). GPT-3, introduit en mai 2020, utilise l'apprentissage en profondeur pour générer du texte qui ressemble étroitement au texte créé par l'homme. Déjà, des applications intéressantes pour GPT-3 ont vu le jour, comme la rédaction d'articles (The Guardian, par exemple, a chargé GPT-3 d'écrire un article sur l'innocuité des robots) et la génération de programmes informatiques.

Les applications de la PNL s'étendent au-delà de GPT-3. La PNL peut être utilisée pour créer du texte à partir de la parole, résumer automatiquement le sens d'une étendue de texte, traduire du texte dans différentes langues, etc.

Bien que la PNL existe souvent à la pointe de la technologie, elle a également fait son chemin dans nos maisons. Les assistants virtuels comme Alexa et Google, par exemple, peuvent traiter les requêtes en langage naturel et les traduire en commandes exécutables. Avec une simple demande vocale, ces assistants IA peuvent rechercher des informations; acheminer les commandes vers des appareils intelligents, tels que des lumières ou des serrures ; et plus encore.

L'avenir de l'IA :un changement de jeu d'entreprise

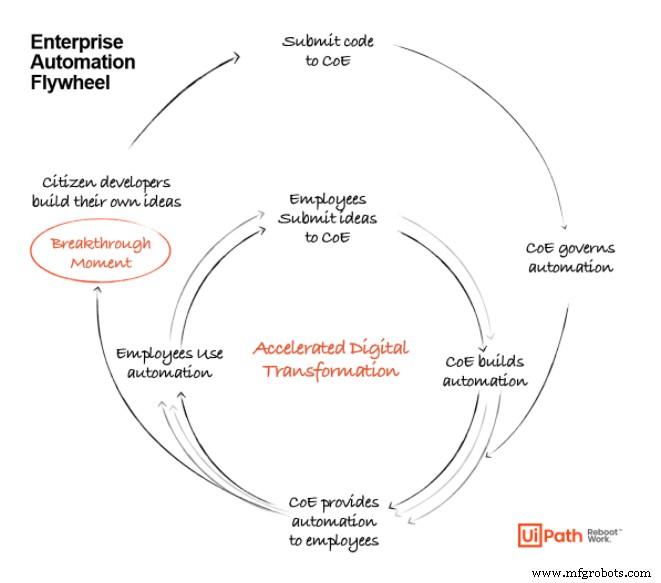

Alors que nous entrons dans la prochaine décennie de maturité technologique, les cas d'utilisation de l'IA en entreprise ne feront que croître. Les outils passés ont jeté les bases de ce qui est possible avec l'IA, mais il reste encore beaucoup de terrain à franchir en mettant ces outils à l'échelle.

Au fur et à mesure que l'IA progressera, nous verrons des entreprises tirer parti de la RPA, de l'apprentissage automatique, de l'exploration de processus et de l'analyse de données pour créer une puissante suite d'automatisation de bout en bout, à mesure que ces technologies deviennent de plus en plus accessibles aux entreprises à tous les stades de maturité. . L'IA ne sera plus le domaine exclusif des chercheurs et des développeurs ; les utilisateurs quotidiens, aidés par des outils modernes, pourront créer des solutions basées sur l'IA aux problèmes qu'ils identifient.

Au fur et à mesure que la technologie devient plus accessible aux utilisateurs professionnels, nous verrons le volant de l'automatisation tourner pour fournir aux entreprises de plus en plus d'idées et de possibilités pour les applications d'IA. Ces possibilités seront soutenues par des plates-formes et des outils d'automatisation de pointe qui redémarreront et révolutionneront notre façon de travailler.

UiPath AI Fabric permet aux utilisateurs de lancer facilement un modèle, d'y pomper des données, d'obtenir des informations et d'évaluer son utilité.

Note de l'éditeur : Alors que le marché de l'automatisation continue d'évoluer, la plate-forme UiPath se met également à jour pour répondre au mieux aux besoins d'automatisation de nos clients. En tant que tel, le nom du produit AI Fabric a évolué depuis la publication initiale de l'article. Pour des informations à jour, veuillez visitez notre page AI Center .

L'IA aujourd'hui :le bon moment pour commencer

Il est temps d'automatiser. Nous avons atteint le stade de l'évolution de l'IA où elle n'est plus théorique :elle est impérative et devrait débloquer des centaines de milliards de dollars de valeur pour les entreprises qui l'adoptent.

Découvrez comment les grandes entreprises utilisent l'automatisation et l'IA pour concrétiser leur vision de devenir une entreprise entièrement automatisée™ :

Système de contrôle d'automatisation

- L'histoire et l'avenir de l'extrusion d'aluminium

- Boston Dynamics &Trimble :l'avenir de la construction

- Usines du futur :fabrication industrielle 1.0 à 4.0

- L'usine "consciente" du futur de Nokia

- L'ingénierie de maintenance du futur

- L'automatisation et l'avenir de la fabrication numérique ?

- L'origine du concept de sciage :histoire et avenir

- Bienvenue dans le futur de la vision 3D

- Cobots contre robots – L'avenir de la fabrication