Les outils remontent la chaîne de valeur pour lever le mystère de Vision AI

Les avantages d'ajouter de la vision aux produits de tous les jours ont attiré l'attention de nombreuses industries et secteurs. Mais comment obtenir réellement les données d'une caméra, intégrer l'apprentissage automatique sur l'appareil pour exécuter l'algorithme d'inférence et permettre le traitement de quelque chose d'utile ?

La réponse, comme dans toute conception de système, est d'avoir les bons logiciels, outils, bibliothèques, compilateurs, etc. Il n'est pas surprenant que de telles capacités soient généralement hors de portée des non-ingénieurs. Mais même parmi les développeurs de systèmes embarqués, les connaissances et les compétences requises pour la conception de systèmes de vision sont considérées comme insuffisantes.

L'un des grands défis est le manque de connaissance des logiciels et des outils disponibles pour développer des systèmes de vision embarqués, comme Jeff Bier, fondateur d'Edge AI and Vision Alliance, l'a expliqué dans un briefing avec EE Times en amont du Sommet de la vision embarquée 2021 . Bien qu'il y ait eu d'importants investissements et recherches sur les algorithmes et le silicium, les outils logiciels qui assurent la médiation entre eux (compilateurs, bibliothèques de fonctions optimisées, etc.) ont été quelque peu négligés, a déclaré Bier.

L'utilisation des bons outils logiciels, compilateurs et bibliothèques peut produire une implémentation très efficace d'un algorithme pour un microcontrôleur ou un processeur particulier. Mais "au cours des 30 dernières années, les sociétés de semi-conducteurs ont généralement sous-investi dans les outils logiciels", a déclaré Bier, un vétéran de l'industrie des systèmes embarqués et du traitement du signal en particulier. « [Le logiciel] est souvent considéré comme un mal nécessairement – c'est un centre de coûts dans une entreprise très sensible aux coûts – et cela se voit. En tant que développeur de logiciels embarqués, vous pouvez comparer les outils à votre disposition par rapport à ceux dont disposent les développeurs de PC ou de cloud et vous sentir comme le beau-fils mal-aimé. »

Portant cet argument au niveau supérieur, il a ajouté :« Vous avez peut-être une expertise en systèmes embarqués, mais il est possible que ces développeurs n'aient jamais travaillé avec des données d'image ou des réseaux de neurones profonds. »

Les compétences sont un grand défi, a déclaré Bier. « Nous avons peut-être fait des calculs sur une feuille de calcul et dit : « Oui, il est possible d'exécuter ce type de réseau de neurones profonds avec des performances suffisantes dans notre application. » Mais savons-nous comment faire cela ? Avons-nous les compétences ? Pour la plupart des organisations, la réponse est non, car elles n'ont pas eu l'occasion d'utiliser cette technologie dans le passé. Comme il s'agit d'une technologie relativement nouvelle dans le monde commercial, ils n'ont pas l'expertise. Ils n'ont pas de service d'apprentissage automatique ni de service de vision par ordinateur dans leur entreprise.

"Au cours des deux dernières années, cela s'est transformé en un très gros goulot d'étranglement en ce qui concerne l'application commerciale de la vision par ordinateur et des réseaux de neurones profonds - juste le savoir-faire."

Cependant, la technologie devient de plus en plus accessible, car les entreprises ont cherché à combler le manque de compétences au cours des deux dernières années. "L'écart de connaissances et de compétences a été assez important mais se réduit", a déclaré Bier, ajoutant que "quelques entreprises", une grande et une petite, "ont mené la charge à ce sujet". La grande entreprise est Intel; le petit est Edge Impulse.

« Intel m'a souvent impressionné par le fait qu'il allait à l'encontre de la tendance et était prêt à faire de gros investissements dans des outils logiciels de plusieurs manières », a déclaré Bier. « Ils ont, par exemple, la chaîne d'outils OpenVINO pour la vision et l'inférence par ordinateur Edge, et DevCloud pour Edge. Edge Impulse est également un environnement basé sur le cloud. Pour un développeur intégré, cela [l'environnement cloud] semble étrange. Tout pour eux se trouve souvent sur leur bureau - la carte de développement, le poste de travail, les outils - et ils n'ont même pas besoin d'une connexion Internet. Tout est très local. C'est donc très étrange de dire : « Mettez votre code dans le cloud » et exécutez les outils dans le cloud. »

La tendance tient compte du délai de déploiement ainsi que du manque de compétences. Une frustration fréquente pour les développeurs embarqués est d'avoir accès aux cartes et aux outils et de les installer correctement, a déclaré Bier. Le calendrier est "généralement mesuré en semaines, parfois en mois, et c'est douloureux, surtout si à la fin vous vous rendez compte que ce n'est pas ce dont vous aviez besoin et que vous devez répéter le processus avec d'autres conseils." Par exemple, vous pourriez constater à la fin du processus que « vous avez besoin du suivant, avec des performances plus élevées ou un ensemble différent d'interfaces d'E/S ».

Mais si le fournisseur « a toutes les cartes de développement dans le cloud connectées à ses machines et [peut] y accéder à volonté, cela offre une commodité énorme. De même, ils ont les dernières versions des outils logiciels, et ils ont trié toutes les dépendances entre eux. »

Ouvrir la voie à la mise en œuvre de la vision

Alors, comment accélérer le déploiement de la vision embarquée pour activer des fonctionnalités telles que la détection et l'analyse d'objets, que ce soit pour les villes intelligentes, les usines, la vente au détail ou toute autre application ?

Ayant réalisé les points douloureux décrits par Bier, les entreprises s'y attaquent. Certains proposent désormais des outils tels que des systèmes de développement basés sur le cloud qui vous permettent d'alimenter votre code ou vos données et d'obtenir des évaluations en un rien de temps. D'autres fournissent des conceptions de référence qui vous permettent simplement de brancher la sortie de votre caméra et de choisir parmi des bibliothèques ou des applications qui fournissent des algorithmes d'inférence pour les applications courantes.

Dans le premier camp, Intel DevCloud pour Edge et Edge Impulse offrent des plates-formes basées sur le cloud qui éliminent la plupart des problèmes avec un accès facile aux derniers outils et logiciels. Dans ce dernier cas, Xilinx et d'autres ont commencé à proposer des systèmes sur module complets avec des applications prêtes pour la production qui peuvent être déployées avec des outils à un niveau d'abstraction plus élevé, éliminant ainsi le besoin de certaines des compétences les plus spécialisées.

Prototyper, comparer et tester l'inférence de l'IA dans le cloud

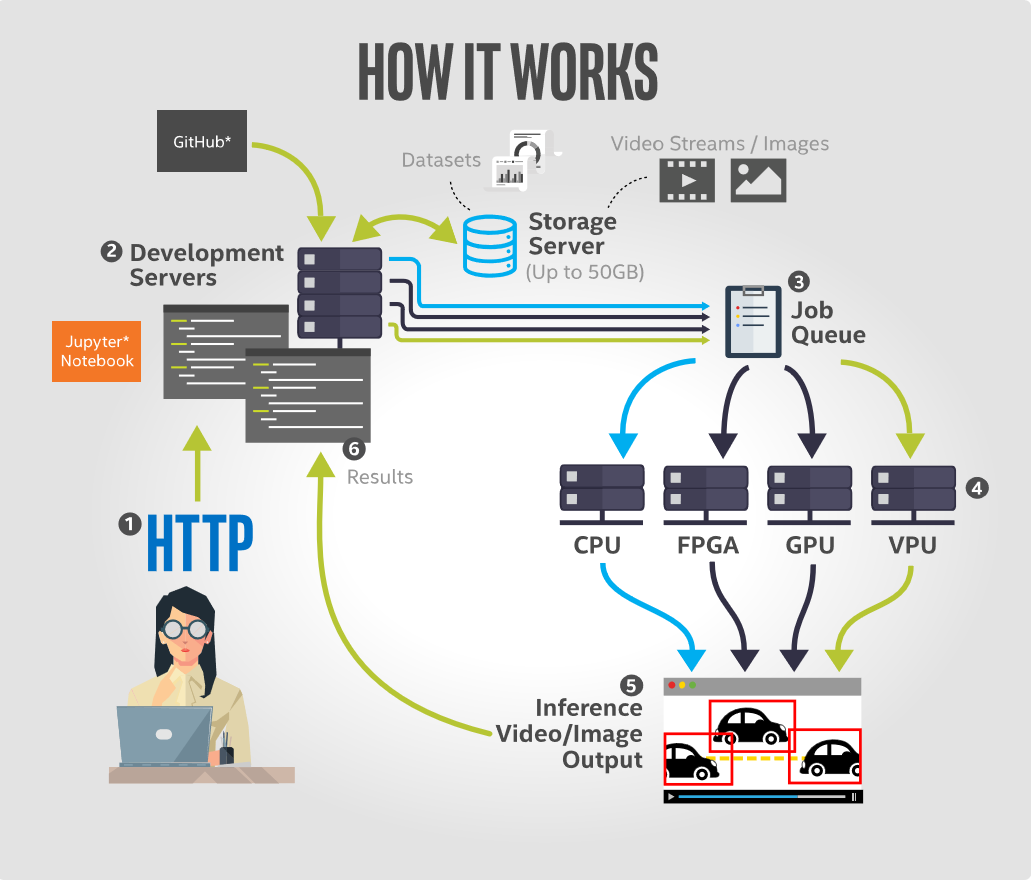

Intel DevCloud for the Edge permet aux utilisateurs de développer, prototyper, comparer et tester des applications d'inférence d'IA sur une gamme de matériel Intel, notamment des CPU, des GPU intégrés, des FPGA et des unités de traitement de vision (VPU). Avec son interface Jupyter Notebook, la plate-forme contient des tutoriels et des exemples préchargés avec tout le nécessaire pour être rapidement opérationnel. Cela inclut des modèles pré-entraînés, des exemples de données et du code exécutable de la dernière version de la distribution Intel de la boîte à outils OpenVINO, ainsi que d'autres outils d'apprentissage en profondeur. Tous les périphériques pris en charge sont configurés pour des performances optimales et prêts pour l'exécution d'inférence.

L'avantage le plus important pour le développeur est que la plate-forme ne nécessite aucune configuration matérielle du côté utilisateur. L'environnement de développement basé sur un navigateur de Jupyter Notebook permet aux développeurs d'exécuter du code à partir de leur navigateur et de visualiser les résultats instantanément. Cela leur permet de prototyper des solutions de vision par ordinateur dans l'environnement cloud d'Intel et de regarder leur code s'exécuter sur n'importe quelle combinaison de ses ressources matérielles disponibles.

Cette offre basée sur le cloud présente trois avantages principaux. Premièrement, il aborde le problème de la paralysie du choix du matériel. Les développeurs peuvent exécuter des applications d'IA à distance sur une large gamme de matériel afin de déterminer celui qui convient le mieux à leur solution en fonction de facteurs tels que le temps d'exécution de l'inférence, la consommation d'énergie et le coût.

Deuxièmement, il offre un accès à distance immédiat au dernier matériel Intel Edge. Du côté des logiciels, il résout le problème de devoir gérer des logiciels obsolètes, car il fournit un accès instantané à la dernière version de la boîte à outils Intel Distribution of OpenVINO et au matériel de périphérie compatible.

Et troisièmement, il offre un accès à des tests de performances spécifiques aux applications dans un format côte à côte facile à comparer.

(Un didacticiel sur l'exécution de modèles de détection d'objets à l'aide d'Intel DevCloud pour Edge est disponible ici.)

Créez un modèle dans le cloud, voyez ce qui se passe en direct

Une autre approche consiste à alimenter en données une plate-forme cloud pour visualiser et créer des modèles de formation et les déployer sur des appareils embarqués. C'est exactement ce que fait Edge Impulse, en offrant un environnement de développement basé sur le cloud qui vise à simplifier l'ajout d'apprentissage automatique sur des appareils de périphérie sans nécessiter de doctorat. en apprentissage automatique, selon l'entreprise.

Sa plate-forme permet aux utilisateurs d'importer des données d'images collectées sur le terrain, de créer rapidement des classificateurs pour interpréter ces données et de déployer des modèles sur des appareils de production à faible consommation. L'une des clés de la plate-forme Web Edge Impulse est la possibilité d'afficher et d'étiqueter toutes les données acquises, de créer des blocs de prétraitement pour augmenter et transformer les données, de visualiser l'ensemble de données d'image et de classer et valider les modèles sur les données d'entraînement directement à partir de l'interface utilisateur.

Parce qu'il peut être assez difficile de créer un modèle de vision par ordinateur à partir de zéro, Edge Impulse utilise un processus d'apprentissage par transfert pour faciliter et accélérer la formation des modèles. Cela implique de s'appuyer sur un modèle bien entraîné et de ne recycler que les couches supérieures d'un réseau de neurones, ce qui conduit à des modèles beaucoup plus fiables qui s'entraînent en une fraction du temps et fonctionnent avec des ensembles de données considérablement plus petits. Avec le modèle conçu, formé et vérifié, il est ensuite possible de déployer ce modèle sur l'appareil. Le modèle peut ensuite fonctionner sur l'appareil sans connexion Internet, avec tous ses avantages inhérents, tels que la réduction de la latence, et fonctionne avec une consommation électrique minimale. Le modèle complet est fourni avec des étapes de prétraitement, des poids de réseau neuronal et un code de classification dans une seule bibliothèque C++ qui peut être incluse dans le logiciel embarqué.

Passer à un niveau d'abstraction supérieur

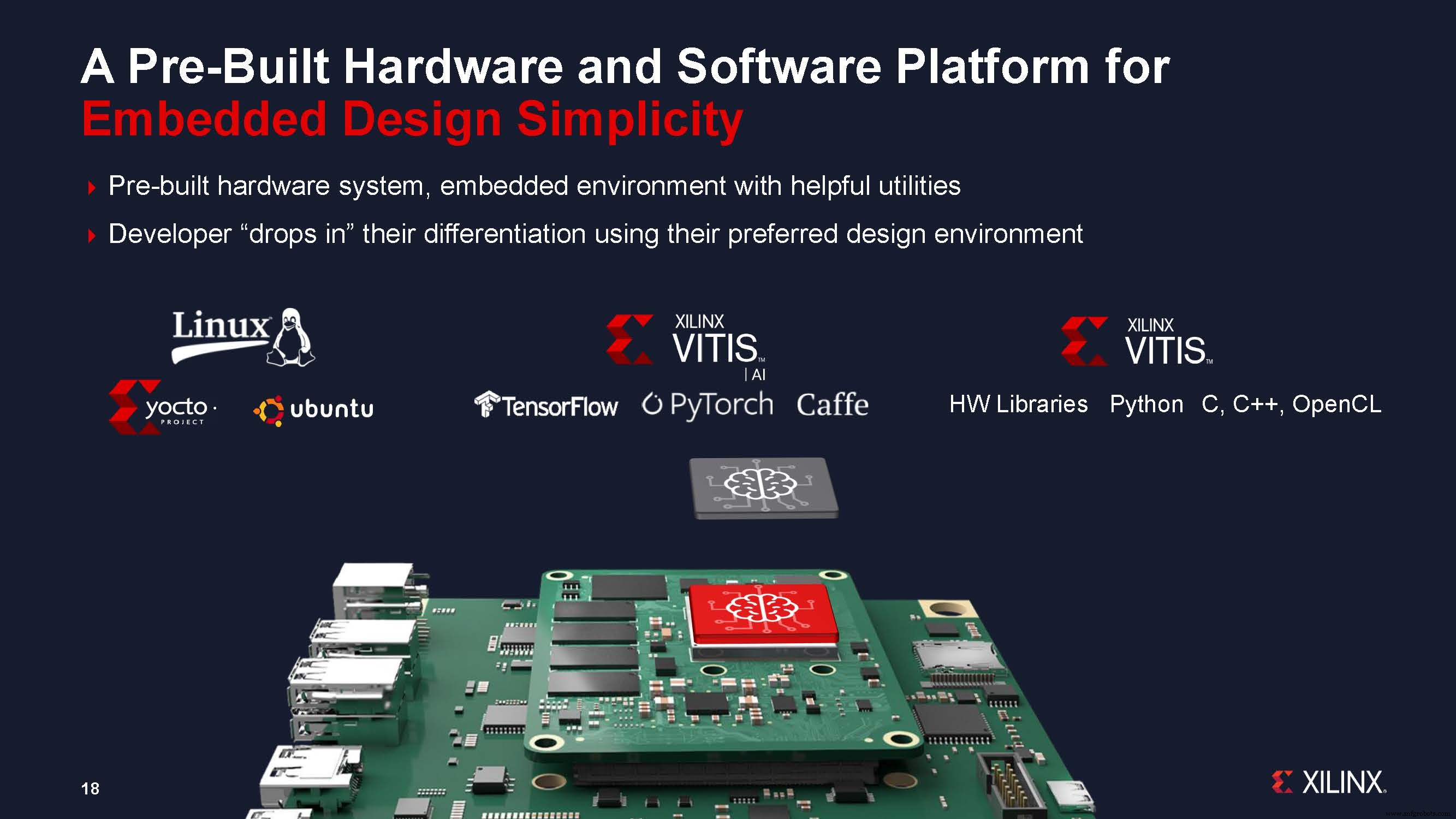

Une autre approche proposée par les fournisseurs consiste à réduire le temps de développement en proposant des systèmes basés sur des modules et en permettant la conception à un niveau d'abstraction plus élevé. Xilinx a déclaré que sa nouvelle approche de systèmes sur module (SOM) peut réduire jusqu'à neuf mois le temps de développement des systèmes de vision, en s'attaquant à la complexité croissante de l'IA de vision ainsi qu'aux défis de la mise en œuvre de l'IA à la périphérie.

Xilinx a récemment annoncé le premier produit de son nouveau portefeuille de SOM :le Kria K26 SOM, ciblant spécifiquement les applications d'IA de vision dans les villes intelligentes et les usines intelligentes, ainsi qu'un kit de développement prêt à l'emploi et à faible coût, le Kria Kit de démarrage de vision AI KV260.

Chetan Khona, directeur de l'industrie, de la vision et de la santé chez Xilinx, a déclaré lors de la conférence de presse pour le lancement de la nouvelle famille de modules :« Les systèmes prêts pour la production sont importants pour un déploiement rapide [de l'IA de vision embarquée]. Les clients peuvent gagner jusqu'à neuf mois en temps de développement en utilisant une conception basée sur des modules plutôt qu'une conception basée sur des appareils. Il a ajouté qu'avec le kit de démarrage, les utilisateurs peuvent démarrer en moins d'une heure, "sans avoir besoin d'une expérience FPGA". Les utilisateurs connectent la caméra, les câbles et le moniteur, insèrent la carte microSD programmée et allument la carte, puis peuvent sélectionner et exécuter une application accélérée de leur choix.

Le portefeuille Kria SOM associe la plate-forme matérielle et logicielle à des applications accélérées par vision prêtes pour la production. Ces applications clé en main éliminent tout le travail de conception de matériel FPGA; les développeurs de logiciels n'ont qu'à intégrer leurs modèles d'IA personnalisés et leur code d'application, et éventuellement modifier le pipeline de vision — en utilisant des environnements de conception familiers, tels que les frameworks TensorFlow, Pytorch ou Café ainsi que les langages de programmation C, C++, OpenCL et Python.

Les SOM Kria permettent également la personnalisation et l'optimisation pour les développeurs embarqués avec le support de PetaLinux standard basé sur Yocto. Xilinx a déclaré qu'une collaboration avec Canonical était également en cours pour fournir la prise en charge d'Ubuntu Linux, la distribution Linux très populaire utilisée par les développeurs d'IA. Cela offre une connaissance généralisée des développeurs d'IA et une interopérabilité avec les applications existantes. Les clients peuvent se développer dans l'un ou l'autre environnement et adopter l'une ou l'autre approche de la production. Les deux environnements seront pré-construits avec une infrastructure logicielle et des utilitaires utiles.

Nous avons mis en évidence trois des approches adoptées par les fournisseurs pour combler le manque de compétences et de connaissances, ainsi que le temps de déploiement, pour le développement de systèmes de vision embarqués. Les approches basées sur le cloud offrent des outils qui « démocratisent » la capacité de créer et de former des modèles et d'évaluer le matériel pour un déploiement extrêmement rapide sur des appareils embarqués. Et l'approche qui propose un module, ou une conception de référence, avec une bibliothèque d'applications permet aux développeurs d'IA d'utiliser les outils existants pour créer rapidement des systèmes de vision embarqués. Tout cela nous amène à une façon différente de voir les cartes et les outils de développement. Ils éliminent le mystère de la vision intégrée en remontant la chaîne de valeur, laissant le travail de base aux outils et modules des fournisseurs.

Contenus associés :

- Vision intégrée au point de basculement

- Cinq tendances à surveiller dans Embedded Vision et Edge AI

- Les machines comprendront-elles jamais pleinement ce qu'elles voient ?

- Xilinx SOM vise une adoption plus large de l'IA de pointe et de la vision intégrée

- Embedded Vision Summit :perception du ML sur les minuscules FPGA

- GWM adopte le SoC Ambarella AI vision pour son nouveau SUV

- AImotive affiche une efficacité de vision de bord de 98 % sur Nextchip Apache5

- La carte de vision AI basse consommation dure « des années » sur une seule batterie

- OmniVision rétrécit le capteur d'images médicales pour une endoscopie plus profonde

Embarqué

- Inspection par vision industrielle :outils du métier

- Applications d'IA dans la chaîne d'approvisionnement mondiale

- Éliminez les conjectures sur les décisions de maintenance

- Drew Troyer :La chaîne de valeur des équipements, partie 3

- Drew Troyer :La chaîne de valeur des équipements, 2e partie

- Drew Troyer :La chaîne de valeur des équipements, partie 1

- La 5G sera-t-elle à la hauteur de la vision 2020 ?

- Maximiser la valeur des données IoT

- La valeur de la mesure analogique