La puce IA gère les charges de travail simultanées

L'entreprise mettra également ses modèles d'IA pour les véhicules autonomes à la disposition des développeurs.

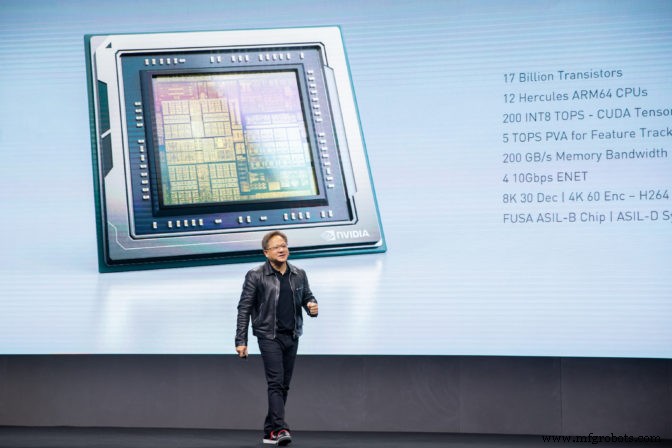

Lors de la GPU Technology Conference (GTC) de l'entreprise à Suzhou, en Chine, le PDG de Nvidia, Jensen Huang, est monté sur scène pour présenter Drive AGX Orin, le SoC de nouvelle génération du portefeuille automobile de l'entreprise.

Orin suit Drive AGX Xavier, lancé il y a un peu moins de 2 ans au CES 2018. Xavier est le SoC phare actuel de Nvidia pour l'accélération de l'IA dans les véhicules.

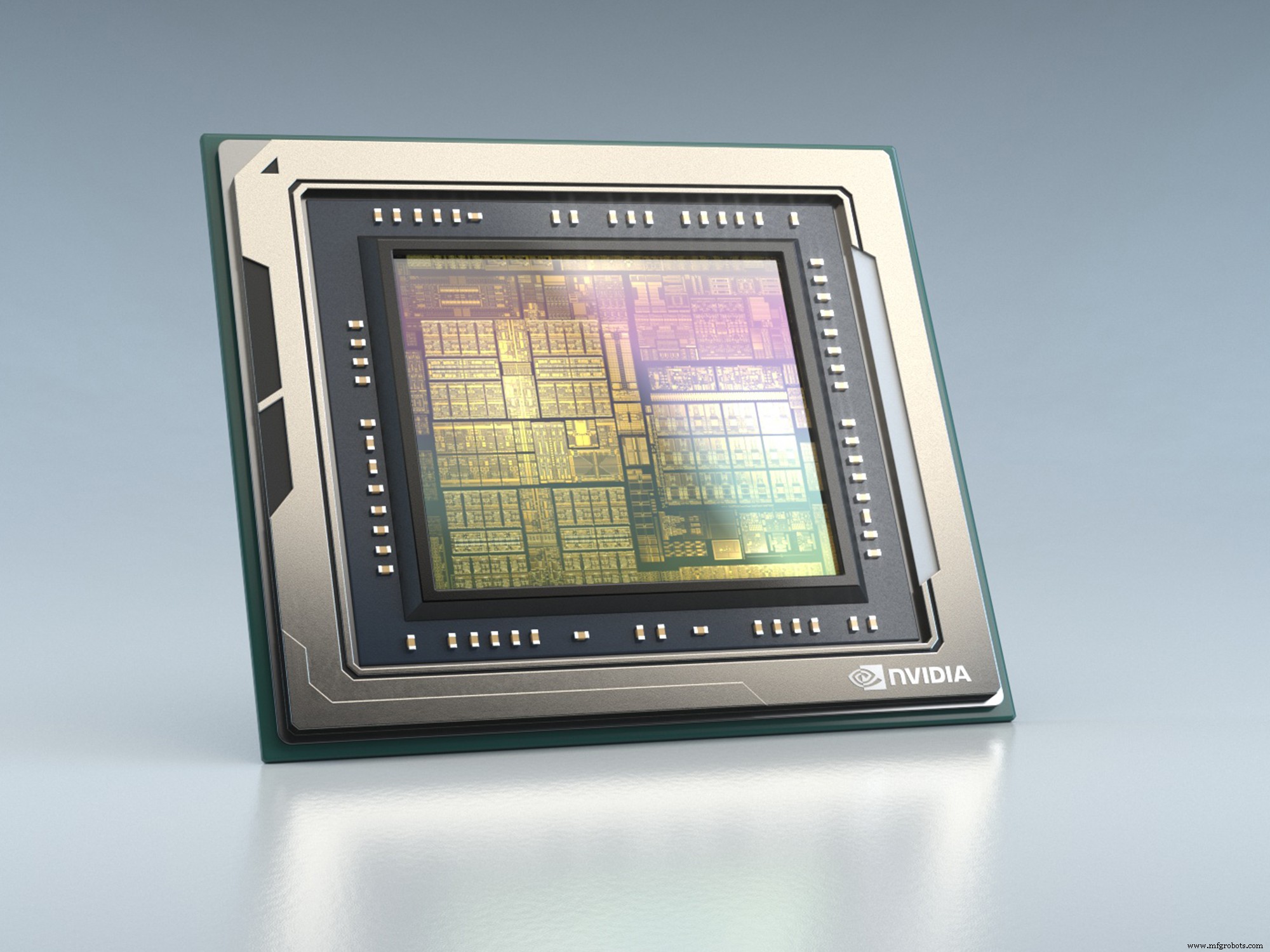

Orin, à 17 milliards de transistors, est presque le double de la taille de Xavier, qui en avait 9 milliards, et il offre près de 7 fois les performances (200 TOPS pour les données INT8). Malgré sa taille, Orin offre également une efficacité énergétique 3 fois supérieure à celle de Xavier, a déclaré la société.

"[C'est] un énorme coup de pouce [en performances], mais il ne s'agit pas seulement du TOPS, il s'agit de l'architecture conçue pour des charges de travail très complexes, des algorithmes très divers et redondants qui doivent fonctionner à l'intérieur d'un véhicule autonome, qui sera géré par le Xavier aujourd'hui et Orin à l'avenir », a déclaré Danny Shapiro, directeur principal de l'automobile chez Nvidia.

Le PDG de Nvidia, Jensen Huang, présente Orin au public lors de la conférence sur la technologie GPU de l'entreprise en Chine (Image :Nvidia)

Orin utilisera 12 processeurs Hercules ARM64 aux côtés de cœurs GPU Nvidia de nouvelle génération et de nouveaux accélérateurs d'apprentissage en profondeur et de vision par ordinateur, ce que la société n'a pas révélé.

Il sera utilisé dans les véhicules autonomes (dans toutes les conceptions du niveau 2 au niveau 5) et la robotique où de nombreux réseaux de neurones et autres applications doivent fonctionner simultanément, tout en atteignant les niveaux de sécurité ISO 26262 ASIL-D. En utilisant la plate-forme Nvidia Drive, Orin sera un logiciel compatible avec Xavier.

La famille Orin comprendra une gamme de configurations basées sur une architecture unique et sera disponible pour les séries de production des clients en 2022.

Apprentissage fédéré

Nvidia a également annoncé un partenariat avec Didi. Didi est un fournisseur de transport basé sur une application (similaire à Uber), actif en Asie, en Amérique latine et en Australie.

Didi utilisera les GPU Nvidia dans son centre de données pour la formation d'algorithmes d'apprentissage automatique et la plate-forme Nvidia Drive pour l'inférence dans ses véhicules autonomes de niveau 4. La société a transformé son unité commerciale de conduite autonome en une société distincte en août. Il lancera également des services cloud GPU virtuels pour les clients basés sur des GPU Nvidia.

Dans une annonce distincte, Nvidia a révélé qu'elle mettrait à la disposition des développeurs de véhicules autonomes des modèles pré-entraînés pour les réseaux de neurones profonds (DNN) qu'il a développés pour Nvidia Drive. Il s'agit notamment de modèles pour la détection de feux de circulation et de panneaux, ainsi que d'autres objets tels que les véhicules, les piétons et les vélos. Ils incluent également des algorithmes de perception du chemin, de détection du regard et de reconnaissance des gestes.

Orin offrira 200 TOPS, 7x les performances de Xavier à 3x l'efficacité énergétique (Image :Nvidia)

Il est important de noter que ces modèles peuvent être personnalisés à l'aide d'outils fournis par l'entreprise et peuvent être mis à jour à l'aide d'un apprentissage fédéré. L'apprentissage fédéré est une technique où la formation est effectuée localement à la périphérie, en préservant la confidentialité des données, avant qu'un modèle central ne soit mis à jour avec les résultats de la formation provenant de plusieurs sources.

"Le véhicule autonome d'IA est un véhicule défini par logiciel nécessaire pour fonctionner dans le monde entier sur une grande variété d'ensembles de données", a déclaré Jensen Huang, PDG de Nvidia. « En fournissant aux développeurs AV un accès à nos DNN et aux outils d'apprentissage avancés pour les optimiser pour plusieurs ensembles de données, nous permettons un apprentissage partagé entre les entreprises et les pays, tout en préservant la propriété et la confidentialité des données. En fin de compte, nous accélérons la réalité des véhicules autonomes mondiaux. »

Embarqué

- Concevoir avec Bluetooth Mesh :puce ou module ?

- Petit module Bluetooth 5.0 intégrant une antenne à puce

- Les chercheurs créent une petite étiquette d'identification d'authentification

- Les processeurs spécialisés accélèrent les charges de travail de l'IA des points de terminaison

- Débuts du processeur radar d'imagerie automobile à 30 ips

- La puce radar de faible puissance utilise des réseaux de neurones à pointes

- La conception de référence prend en charge les charges de travail d'IA gourmandes en mémoire

- Capteur poumon-cœur miniature sur puce

- Que sont les convoyeurs à copeaux ?