Le banc d'essai de l'apprentissage automatique étend la prise en charge des charges de travail de périphérie et de centre de données

L'organisation d'analyse comparative ML Commons a publié une nouvelle série de scores MLPerf Inference. Ce dernier cycle est séparé en classes d'appareils pour faciliter la comparaison. Les résultats présentent également une gamme de nouveaux modèles d'IA, qui sont destinés à représenter une gamme de charges de travail différentes qui sont déployées commercialement mais toujours considérées comme à la pointe de la technologie.

Les systèmes accélérés par Nvidia ont représenté environ 85 % du total des soumissions, remportant toutes les catégories auxquelles ils ont participé. Cependant, il n'y a eu aucune soumission Nvidia dans les classes Mobile ou Notebook (Nvidia n'est pas présent sur ces marchés avec des produits d'accélération de l'IA). Il y a également eu plusieurs soumissions intéressantes de startups, et dans l'ensemble une plus grande tendance à avoir des nombres dans plusieurs colonnes, ce qui facilite les comparaisons.

Changements par rapport au dernier tour

Le premier changement majeur apporté aux résultats de ce cycle est que les systèmes ont été séparés en classes :centre de données, périphérie, mobile et ordinateur portable. Les téléphones portables et les ordinateurs portables ont des facteurs de forme et des profils de performances très spécifiques, ce qui les rend faciles à distinguer de la liste de bord plus large.

« Si vous parlez d'un ordinateur portable, il exécute probablement Windows, si vous parlez d'un smartphone, vous utilisez probablement iOS ou Android », a déclaré David Kanter, directeur exécutif de ML Commons à EE Times . "Séparer ces résultats du plus grand pool de scores d'inférence est très utile pour rendre les choses plus claires."

Les références pour cette deuxième série de scores d'inférence ont également été remaniées pour inclure des modèles d'IA qui représentent des cas d'utilisation modernes. Alors que le cycle précédent se concentrait sur les modèles de vision et de traitement d'images, cette fois, les classes de centre de données et de périphérie incluent le modèle de recommandation DLRM, le modèle d'imagerie médicale 3D-UNet qui est utilisé pour rechercher des tumeurs dans les IRM, le modèle parole-texte RNN- T et le modèle de traitement du langage naturel (NLP) BERT.

« [La sélection du modèle] est motivée par les commentaires des clients, mais nous ne voulons pas tomber dans le piège consistant à demander aux étudiants de définir leur propre test », a déclaré Kanter, expliquant que l'objectif était d'identifier les modèles de pointe qui sont en production, pas seulement dans la phase de recherche. « DLRM et 3D-UNet, ceux-ci étaient des [choix] très informés conduits par notre conseil consultatif, des gens du monde médical, des gens qui font des recommandations à grande échelle… Ce type de construction de charge de travail éclairée est extrêmement précieux. »

Les classes mobiles et notebook utilisent MobileNetEdge pour la classification d'images, SSD-MobileNetv2 pour la détection d'objets, Deeplabv3 pour la segmentation d'images et Mobile BERT pour la PNL.

Dans l'ensemble, les objectifs de précision ont également été augmentés pour refléter les déploiements dans le monde réel.

L'analyse ci-dessous se réfère uniquement à la division « fermée » pour une comparaison équitable.

Résultats du centre de données

Comme prévu, la majorité des soumissions dans la classe des centres de données ont utilisé des accélérateurs GPU Nvidia. Les autres utilisaient des processeurs Intel pour le traitement de l'IA, à quelques exceptions près (voir ci-dessous). Aucune soumission de Google pour son TPU cette fois, et aucune soumission de quiconque dans la communauté vocale des startups qui s'implantent dans cet espace (Graphcore, Cerebras, Groq, etc.).

"L'avance de [Nvidia] sur les processeurs est passée d'environ 6X à 30X sur un modèle de vision par ordinateur de base appelé ResNet, et sur des modèles de système de recommandation avancés… Nvidia A100 est 237 fois plus rapide que le processeur [Intel] Cooper Lake ", a déclaré Paresh Kharya , directeur principal de la gestion des produits et du marketing chez Nvidia. "Un seul DGX-A100 offre les mêmes performances sur les systèmes de recommandation que 1000 serveurs CPU, et une valeur incroyable pour les clients."

Mipsology était le seul entrant non-CPU non-GPU disponible dans le commerce dans cette division. La société dispose d'une technologie d'accélérateur appelée Zebra qui fonctionne sur des FPGA Xilinx (dans ce cas, un Xilinx Alveo U250). Leur technologie peut gérer 4096 requêtes ResNet par seconde en mode serveur (contre environ 5563 pour un Nvidia T4) ou 5011 échantillons par seconde en mode hors ligne (contre environ 6112 pour le Nvidia T4).

La société taïwanaise Neuchips a soumis un score dans la catégorie Recherche, Développement ou Interne, ce qui signifie que l'appareil qu'elle a utilisé n'est pas disponible dans le commerce et ne le sera probablement pas avant au moins 6 mois. RecAccel est conçu spécifiquement pour accélérer DLRM, le modèle de recommandation utilisé dans ce benchmark. Il utilise une conception massivement parallèle fonctionnant sur un FPGA Intel Stratix pour l'inférence d'IA. Ses résultats dans la catégorie DRLM étaient comparables ou pires que les processeurs Intel Cooper Lake et ne correspondaient pas à Nvidia.

Résultats de pointe

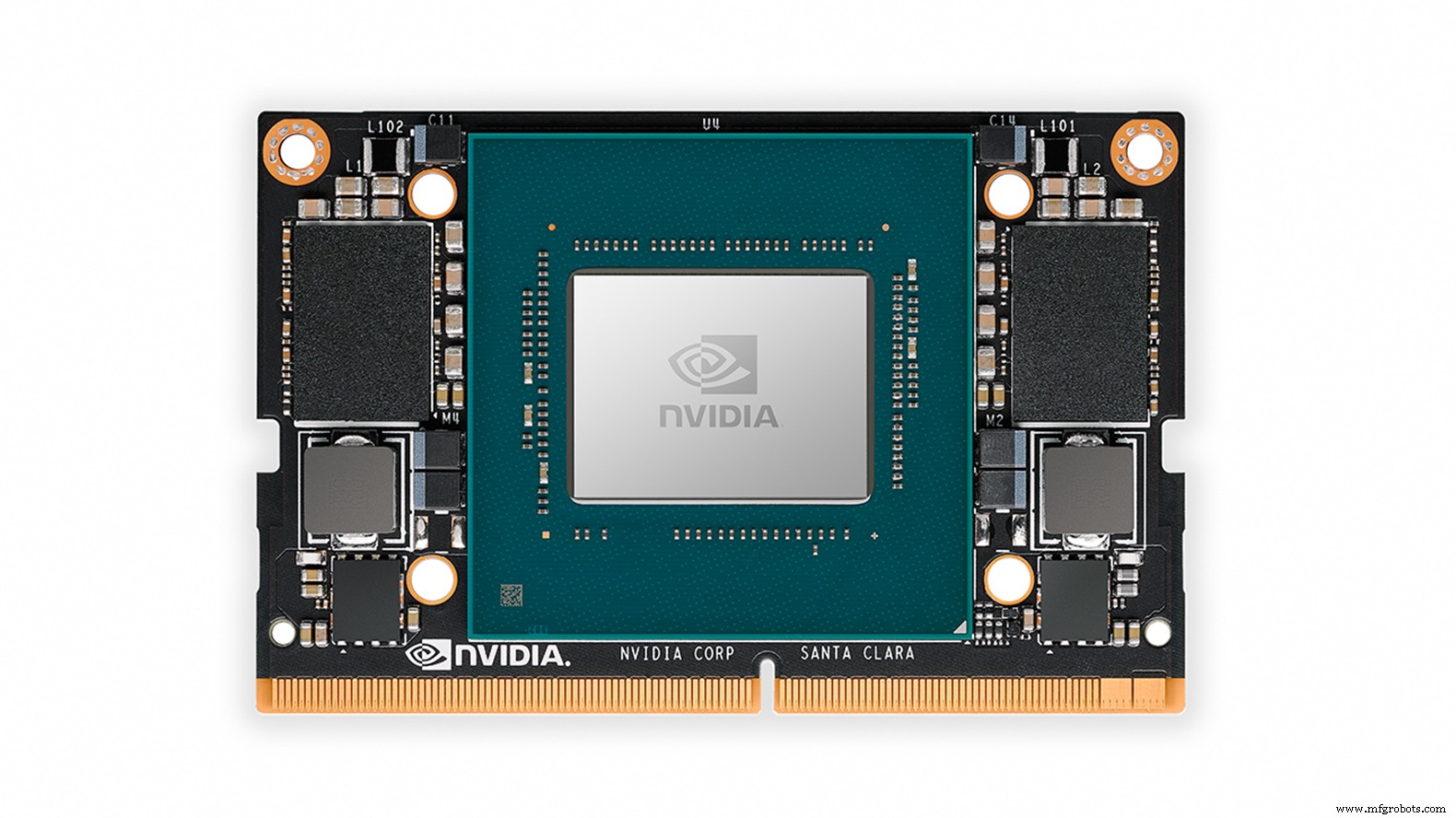

La catégorie Edge a été dominée par les scores accélérés par les A100, T4, AGX Xavier et Xavier NX de Nvidia.

Centaur Technology a entré les résultats de son système de conception de référence disponible dans le commerce qui utilise le processeur de serveur de Centaur basé sur sa microarchitecture x86 interne, ainsi qu'un accélérateur d'IA interne séparé en tant que coprocesseur. Cette conception de référence est un système de classe serveur pour les applications sur site ou de centre de données privé et il est optimisé pour le coût et le facteur de forme (plutôt que la consommation d'énergie ou les performances de pointe), selon Centaur.

Sur la classification d'images ResNet (latence de flux unique), le système de Centaur était plus rapide que les propres soumissions de Nvidia pour les systèmes de serveurs équipés du Tesla T4. Cependant, le T4 a battu la conception de Centaur sur les échantillons hors ligne ResNet traités par seconde. Cependant, Centaur n'a pas aussi bien réussi en matière de détection d'objets, se situant quelque part entre les deux modules de périphérie intégrés de Nvidia, le Xavier NX et l'AGX Xavier.

Le cabinet d'ingénierie britannique dividiti, spécialisé dans l'évaluation objective des systèmes matériels et logiciels de ML, a soumis une série de notes sur des systèmes allant de Fireflys et Raspberry Pis à Nvidia AGX Xavier. Des scores apparemment identiques pour les entrées Raspberry Pi utilisent en fait des systèmes d'exploitation différents (Debian 32 bits contre Ubuntu 64 bits – Ubuntu était environ 20% plus rapide). Les résultats de la société différaient des résultats de Nvidia pour AGX Xavier, car Nvidia utilisait à la fois le GPU AGX Xavier et deux accélérateurs d'apprentissage en profondeur sur puce pour ses scores ResNet Offline et Multistream, où dividiti n'utilisait que le GPU.

Un porte-parole de Dividiti a également déclaré à EE Times que si la société avait réussi à reproduire « plus ou moins » les scores de Nvidia pour le cycle d'inférence précédent, les derniers résultats ont introduit une régression des performances dans le harnais de test qui n'a été remarquée que quelques minutes avant la date limite de soumission (la correction de cette erreur a ensuite amélioré certaines latences en 10-20%). Cela sert à illustrer l'importance de la combinaison matériel/logiciel sur les résultats.

La catégorie Edge a été dominée par les résultats accélérés par les GPU Nvidia, y compris le Jetson Xavier NX (Image :Nvidia)

Les nouvelles entrées dans cette catégorie incluent IVA Technologies et Mobilint, toutes deux dans la catégorie Recherche, Développement ou Interne.

IVA Technologies, un concepteur et fabricant russe d'équipements informatiques, a travaillé sur une puce d'accélérateur d'IA qui prend en charge les modèles convolutifs, 3D-convolutionnels et LSTM. La société a soumis un score labellisé « FPGA » qui pourrait être un prototype de l'accélérateur ASIC implémenté sur un FPGA. La latence de flux unique ResNet était de 12,23 ms, environ 4 fois plus lente que le Xavier NX, et il traitait 89 échantillons hors ligne par seconde, soit moins d'un dixième du Xavier NX. Cependant, la catégorie Edge est large et on en sait peu sur la conception - elle pourrait être destinée à des appareils plus petits que le Xavier NX.

Mobilint, une start-up ASIC coréenne d'accélérateurs d'IA, a soumis une note pour sa conception Mobilint Edge, qui EE Times suspects a été implémenté en tant que prototype sur une carte FPGA Xilinx Alveo U250. Sur ResNet, sa latence était beaucoup plus longue que la conception d'IVA Technologies à 37,46 ms, mais il traitait plus d'échantillons hors ligne par seconde (107). La société a également soumis des scores pour la détection d'objets.

Bien que ni IVA Technologies ni Mobilint n'aient produit de scores révolutionnaires, il est certainement utile de comparer les prototypes, car cela prouve que les piles de logiciels qui les accompagnent sont prêtes.

Résultats mobiles

Dans la nouvelle catégorie SoC mobile, il y avait trois soumissions qui étaient assez bien assorties, sans gagnant clair.

MediaTek a soumis des scores pour son Dimensity 820 (dans le smartphone Xiaomi Redmi 10X 5G). Cet appareil utilise la propre unité de traitement AI (APU) 3.0 de MediaTek, qui est un accélérateur compatible FP16 et INT16 optimisé pour les fonctions de caméra/imagerie. Le SoC dispose également d'un GPU à 5 cœurs.

Le Qualcomm Snapdragon 865+ utilise le processeur Hexagon 698 de l'entreprise conçu pour l'accélération de l'IA qui tourne à 15 TOPS, aux côtés du GPU Adreno 650. Les tests ont été exécutés sur un Asus ROG Phone 3.

L'Exynos 990 de Samsung a été évalué dans le cadre du Galaxy Note 20 Ultra. Cet appareil contient un NPU (unité de traitement neuronal) double cœur et un GPU Arm Mali-G77 ainsi que divers cœurs de processeur Arm.

L'Exynos 990 de Samsung a été le meilleur en classification d'images et en PNL ; le MediaTek Dimensity 820 était très proche sur la classification des images mais Samsung avait une avance plus nette sur la PNL. MediaTek avait une nette avance dans la détection d'objets, avec le Qualcomm Snapdragon 865+ à la deuxième place. MediaTek a également remporté le benchmark de segmentation d'images, devant Qualcomm de peu.

Résultats du notebook

Il n'y avait qu'une seule entrée dans la catégorie Notebook – une conception de référence Intel qui utilise le prochain GPU Intel Xe-LP comme accélérateur. Le Xe-LP est la version basse consommation du Xe-HP et du Xe-HPC qui sont destinés à l'accélération de l'IA des centres de données et au HPC ; aucun des plus gros appareils n'a été comparé.

Comme il n'y avait qu'une seule entrée dans cette classe, il est difficile d'interpréter les résultats du Xe-LP. Cependant, la catégorie des ordinateurs portables a utilisé les mêmes modèles d'IA que la catégorie des mobiles, une comparaison est donc inévitable. Le plus grand avantage de Xe-LP par rapport aux SoC mobiles était la segmentation d'images (DeeplabV3), où il surpassait le gagnant mobile d'un facteur 2,5 en termes de débit (images par seconde). Ses performances les plus faibles étaient sur la détection d'objets (SSD - MobileNetv2) où son avantage était de 1,15x sur le vainqueur mobile en termes de débit (images par seconde).

Futurs repères

À l'avenir, Kanter espère que les futures séries d'évaluations comprendront davantage d'entrées de processeurs non-Nvidia et non-Intel, affirmant que l'organisation a fait tout son possible pour encourager les startups et les petites entreprises à soumettre des résultats.

"Nous avons une division ouverte, où vous pouvez soumettre n'importe quel réseau que vous voulez", a-t-il déclaré. « L'une des bonnes choses à ce sujet est que si un client dit que je veux X, et que vous faites toute l'activation pour cela, vous pouvez utiliser X, tant que vous pouvez déposer le code afin que nous puissions voir ce que vous exécutez. ”

Les entreprises peuvent soumettre des résultats pour un seul modèle d'IA afin de réduire les efforts d'ingénierie, et peuvent même soumettre leurs propres modèles dans la catégorie ouverte.

Kanter a également mentionné que l'organisation avait l'intention d'introduire une dimension de mesure de la puissance dans la prochaine série de scores. Les travaux sont déjà en cours.

"L'une des choses auxquelles nous aimerions impliquer les gens est d'aider à construire l'infrastructure de mesure de la puissance - aidez-nous à développer les outils pour effectuer ces mesures", a déclaré Kanter.

La liste complète des résultats d'inférence MLPerf en détail est disponible ici.

>> Cet article a été initialement publié le notre site partenaire, EE Times.

Embarqué

- ST :capteur de mouvement avec apprentissage automatique pour un suivi d'activité haute précision et économe en batterie

- ADLINK :solution d'IA et de machine learning multi-accès montée sur poteau

- NXP double l'apprentissage automatique à la périphérie

- Les tendances continuent de pousser le traitement vers la périphérie pour l'IA

- Fonctionnalités du centre d'usinage vertical pour améliorer la productivité

- Un réseau Wi-Fi optimisé est essentiel au succès Edge

- Apprentissage automatique sur le terrain

- L'Edge est désormais le centre de l'action

- Centre de tournage pour applications lourdes