Vision et robotique :heureux ensemble

Le prochain "duo dynamique" n'impliquera peut-être pas du tout d'humains. "La vision industrielle et les robots forment un mariage parfait", a déclaré Klas Bengtsson, chef de produit mondial, systèmes de vision pour ABB Robotics (Auburn Hills, MI). Ce n'est pas nouveau. Vision et robotique vont de pair depuis des années. Mais contrairement à d'autres mariages, celui-ci est en plein essor à mesure que la vision artificielle augmente ses capacités et trouve de nouvelles applications. Le mariage « parfait » du passé impliquait de guider le robot. Mais de nouvelles applications, comme les enfants d'un bon mariage, incluent désormais l'inspection des pièces, la lecture des codes à barres ou QR pour la traçabilité, et la recherche de nouvelles façons d'emballer et de déballer les pièces.

Tout se résume à la flexibilité que la vision artificielle offre . "Vision a aidé ABB à améliorer les capacités de nombreuses applications robotiques", a-t-il déclaré.

Le besoin de robots de guidage flexibles a été motivé par la diversité croissante des produits et la nécessité de raccourcir les délais de livraison dans de nombreuses industries. Pourquoi la flexibilité est-elle si importante ? "Si vous codez en dur l'automatisation robotique, dès que vous modifiez un produit ou quelque chose dans votre chaîne de production, vous devez modifier le programme", a déclaré Bengtsson. Cela signifie également modifier le montage de précision ou la manière de placer une pièce afin qu'un programme de guidage de robot codé en dur puisse sélectionner, polir ou opérer de manière fiable sur la pièce. Les coûts s'additionnent.

La vision industrielle aide à contenir ces coûts en permettant au robot de « voir » les variations de pièces et d'orientation. Les capteurs de balayage 3D ouvrent encore plus de nouvelles applications. Dit Bengtsson, "La question d'il y a 15 ans était 'Pourquoi utiliser la vision artificielle.' La question d'aujourd'hui est :'pourquoi pas ?'"

Les humains et les robots collaborent

Rethink Robotics (Boston), fondée en 2008, construit des robots collaboratifs, ou cobots. Son produit phare est Sawyer. "Un cobot comme notre robot Sawyer est mieux utilisé pour effectuer des tâches répétitives et banales à l'échelle humaine", a déclaré Mike Fair, chef de produit. Cela signifie travailler avec des produits ou des mouvements qui reproduisent ce que fait un humain, mais qui est également extrêmement répétitif et banal.

"Des applications comme celle-ci incluent l'emballage, l'entretien des machines, le chargement et le déchargement des lignes, l'inspection et les tests de cartes de circuits imprimés", a-t-il déclaré. La manutention des matériaux pour les machines CNC est une autre application, remplaçant un humain qui charge une machine CNC, la fait tourner, attend la fin de la tâche d'usinage, puis décharge la machine.

Rethink croit tellement en la vision artificielle qu'il intègre une caméra au poignet de chaque Sawyer. "Le système de vision embarqué [rend] notre cobot plus rapide et plus facile à déployer, éliminant les tracas et le temps d'intégration coûteux des systèmes de vision industrielle typiques. Nous ajoutons un logiciel pour faciliter le déploiement de [ces] systèmes de vision », a déclaré Fair. Lors du salon ATX West 2018, il a fait une démonstration prouvant que même un journaliste peut programmer une tâche simple en quelques minutes. En conjonction avec des autocollants codés qui ressemblent à des codes QR, leur logiciel aide le robot à se positionner pour s'adapter à la variabilité de la cellule de travail. Cela facilite également le déplacement des robots Sawyer d'une tâche à l'autre et d'un emplacement à l'autre.

Universal Robots USA Inc. (UR ; Ann Arbor, MI) se consacre également aux robots collaboratifs. Ses trois robots, dont la charge utile varie de 3 à 10 kg, fonctionnent au sein d'un « écosystème » de fournisseurs tiers. Il propose un programme de développement gratuit appelé Universal Robots+ pour permettre aux fournisseurs tiers d'effecteurs finaux, de systèmes de vision et d'autres périphériques de développer des modules complémentaires plug-and-play avec ses cobots.

Le site Web de l'entreprise présente six différentes options de vision dans cet écosystème adapté au pick and place, à l'automatisation des machines CNC, à l'emballage et à la palettisation, à l'assemblage, au vissage et à l'entretien des machines. Des scanners 2D et 3D sont disponibles. Plusieurs progiciels de contrôle et de simulation de mouvement de robot sont disponibles.

Intégration, facilité d'utilisation

Pour que la vision artificielle soit utile, elle doit être accessible, un élément important de l'écosystème d'UR. Par exemple, l'un de leurs packages tiers s'appelle Universal Metrology Automation, proposé par 3D Infotech. Il offre l'intégration de systèmes de contrôle de mouvement, de scanners 3D et de logiciels d'inspection pour créer une solution de métrologie configurable et automatisée. D'autres programmes offrent une programmation en ligne ou hors ligne, un logiciel de simulation robotique et des capacités de surveillance.

« Aujourd'hui, l'intégration avec les robots et les systèmes de vision est bien meilleure », a déclaré Rob Antonides, président d'Apex Motion Control (Surrey, Colombie-Britannique). Apex est un intégrateur qui a pleinement tiré parti de l'approche écosystémique d'UR. « Auparavant, nous devions assembler des systèmes de vision avec des contrôleurs de robots, mais aujourd'hui, ils sont plus transparents en plug-and-play, via Ethernet IP ou tout type de réseau. Il y a vingt ans, il me fallait une semaine pour mettre en place un système robotique guidé par la vision et les communications ; aujourd'hui, c'est 15 à 20 minutes.”

La vision industrielle s'est avérée particulièrement utile pour Apex. Les tâches qu'il a automatisées comprennent une variété d'opérations de cuisson, y compris la décoration de gâteaux. « Les systèmes de vision vous permettent de gérer les incohérences et la présentation et le positionnement moins que parfaits du produit. Nous cartographions la surface d'un gâteau avec un capteur 3D afin de pouvoir le décorer rapidement et facilement », a déclaré Antonides.

FANUC met également l'accent sur la facilité d'intégration. "Nous avons lancé un tout nouveau contrôleur à la fin de l'année dernière, doté de fonctions importantes pour la vision robotique intégrée", a expliqué David Dechow, ingénieur du personnel en robotique intelligente/vision artificielle pour FANUC America Corp. (Rochester Hills, MI). "Chez FANUC, tous nos systèmes de vision sont désormais intégrés dans le contrôleur." FANUC a été l'une des premières sociétés de robots à inclure la vision pour la robotique de guidage, en l'offrant il y a 30 ans en option dans ses systèmes de guidage robotique.

Dechow a également observé que les entreprises de vision industrielle se sont concentrées sur le développement d'interfaces plus simples avec des robots. "Les fournisseurs de vision soutiennent sensiblement ce marché", a-t-il déclaré. « Le gros du travail pour faire fonctionner la collaboration se situe du côté de la vision. Le robot attend un point. L'astuce consiste à utiliser la vision artificielle pour trouver le bon point, en fusionnant le système de coordonnées du système de vision artificielle avec le système de coordonnées du robot. Il a convenu avec d'autres personnes interrogées pour cet article que la vision artificielle offre une flexibilité incomparable dans de nombreuses tâches d'automatisation. Aujourd'hui, le rapport coût/bénéfice commence à favoriser la vision plutôt que la fixation de précision et le codage en dur, a-t-il déclaré.

IA :Pose et discrimination

Une discussion sur la vision, les données et les robots conduit naturellement à la question de l'utilité de l'intelligence artificielle (IA) pour les robots voyants. Dechow a noté un hic :l'IA n'est pas particulièrement applicable au guidage robotique. "L'apprentissage de l'IA est exceptionnellement bon pour la catégorisation et la différenciation. Ce qu'il n'est pas bon, c'est l'analyse discrète », a-t-il expliqué. Un robot doit se déplacer vers un point discret. Combiné à des systèmes de métrologie, il mesure des grandeurs géométriques discrètes. "Il n'y a rien à apprendre", a-t-il dit.

Mais cela ne s'arrête pas là. Si cela ne s'applique pas au guidage, il existe des tâches robotiques où l'IA offre de la valeur. "Par exemple, l'identification et la classification d'un objet par rapport à son arrière-plan pour déterminer l'objet sur lequel le robot doit opérer, combinées à un guidage robotique, constitueraient une bonne application hybride", a-t-il déclaré. Un autre est dans l'optimisation du pick and grip. "Trouver l'orientation idéale du bras dans l'espace et la trajectoire d'approche relève d'un domaine d'apprentissage plutôt que [d'être] déterministe. Il existe de nombreuses orientations qui sont à la fois bonnes et mauvaises », a-t-il expliqué. "L'IA est particulièrement utile lorsque les pièces sont aléatoires et non homogènes dans leur emplacement et leur taille."

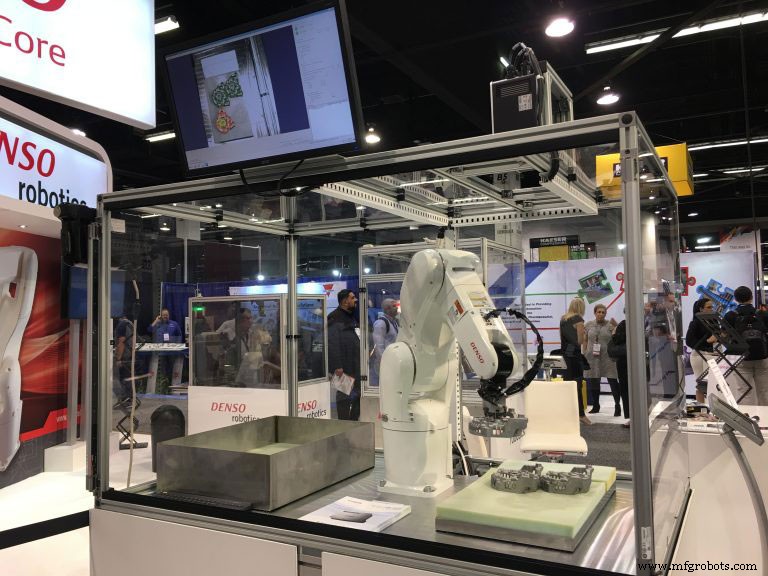

Peter Cavallo de Denso Products and Services Americas Inc. (Long Beach, CA) a convenu que l'augmentation substantielle de la capacité du système de vision est à la fois réelle et a ouvert de nouvelles opportunités pour les applications robotiques. « Dans sa forme la plus simple, [la vision] trouve une pièce ou un objet et opère dessus. Dans sa forme la plus complexe, que nous voyons maintenant, il peut voir les choses, interpréter, reconnaître et voir la pièce pour ce qu'elle est, même dans différentes configurations ou positions, sans déplacer la pièce ou le robot. »

Il considère la numérisation 3D comme un développement particulièrement important, simplifier les tâches auparavant difficiles telles que le ramassage des poubelles. Le dernier système de Denso utilise un système de vision de la lumière structurée pour voir en 3D avec un détecteur CMOS.

Sa vision de l'application de l'IA à la robotique est basée sur un contexte système plus large. "Alors que nous passons à la prochaine génération de robots, nous commençons à nous lancer dans des choses comme l'apprentissage en profondeur, où la vision devient partie intégrante d'un système entier", a-t-il expliqué. "Nous avons présenté quelque chose au salon des robots de Tokyo qui montrait un apprentissage en profondeur dans un système à 28 degrés de liberté qui comprenait deux robots avec des mains qui préparaient une salade." Pourquoi les utilisateurs industriels devraient-ils être impressionnés ? Le robot a sélectionné la laitue, les fruits et les légumes en utilisant uniquement les connaissances fournies au préalable. « Nous n'avons pas programmé le robot; au lieu de cela, nous lui avons dit ce que nous voulions », a-t-il déclaré. Pensez au nombre de tâches non structurées qui existent dans l'atelier et qui seraient idéales pour une telle automatisation.

Pas seulement pour les gros joueurs

La vision artificielle, l'intégration, les logiciels et même l'IA peuvent faire penser que ce niveau d'automatisation robotique est réservé aux entreprises du Fortune 500. Ce n'est pas le cas. « Il s'applique parfaitement aux petites et moyennes entreprises, car la vision est aujourd'hui d'un coût raisonnable. Ce qui était auparavant de 50 000 $ à 100 000 $ est maintenant inférieur à 5 000 $. Il n'y a aucune raison d'être timide », a déclaré Cavallo.

Rick Brookshire, chef de produit pour Epson America Inc. (Carson, Californie), a convenu que l'automatisation robotique est idéale pour les petites et moyennes entreprises (PME). "En plus des gros clients qui achètent 50, 100 ou même 1000 robots, nous avons de nombreux petits clients qui achètent un, deux ou trois robots", a-t-il déclaré. Epson se spécialise dans les robots plus petits optimisés pour les tâches de haute précision, développant son activité de robots à partir de ses propres besoins dans la construction de montres de haute précision. "Tous nos robots sont disponibles avec un guidage visuel intégré, une fonctionnalité qui est de plus en plus acceptée. Il devient également plus fiable. Les gens sont plus disposés à l'utiliser », a-t-il déclaré.

Comme d'autres interviewés pour cette histoire, il croit à la simplicité est vital, en particulier pour répondre aux besoins des PME. Le programme Epson Vision Guide utilise une interface graphique pointer-cliquer basée sur des objets, permettant aux développeurs de développer rapidement des applications, selon la société. Alors que l'application idéale d'un robot guidé par la vision est quelque chose où les pièces ne sont pas bien positionnées dans un niveau de tolérance raisonnable, ou ne peuvent pas être présentées de manière cohérente, la précision fournie par les robots Epson ouvre un autre domaine d'utilisation.

Les tolérances se resserrent. Les pièces deviennent plus petites. Le placement de précision devient de plus en plus difficile. "C'est là que les robots de précision tels que ceux d'Epson peuvent aider", a-t-il déclaré. « Cela se produit de plus en plus dans les petites entreprises. Et ces robots deviennent si faciles à utiliser que beaucoup de nos clients effectuent eux-mêmes l'intégration. Les robots placent même des vis de moins de 0,7 mm de diamètre. À mesure que la main-d'œuvre vieillit, cela peut devenir un facteur critique.

James Cooper, vice-président des ventes pour Applied Manufacturing Technologies (AMT ; Orion, MI), a une perspective unique basée sur son expérience dans l'industrie de la fabrication automobile. AMT est un intégrateur système spécialisé dans les systèmes robotiques guidés par la vision. Les numéros de pièces multiples avec des systèmes complexes, comme dans les cas de transmission, sont de plus en plus répandus. Un carter de transmission est un gros objet avec de nombreux trous et des surfaces complexes, idéal pour la vision mais coûteux pour une fixation dure de précision. « La taille des lots diminue également avec des changements plus fréquents. C'est pourquoi les systèmes de vision guidés par robot deviennent si critiques dans de nombreuses applications. Il a également observé la croissance des systèmes de vision 3D, en particulier dans les applications de prélèvement de bacs et de bacs.

Cela va au-delà du guidage. "L'inspection de la qualité est une application idéale, recherchant la présence et l'absence de trous et d'autres caractéristiques ou déterminant si un composant a été correctement assemblé", a-t-il déclaré. Un autre domaine riche est celui de l'inspection métrologique. « Nous avons construit avec notre partenaire Hexagon un système basé sur un robot collaboratif qui inspecte le produit d'un client. Auparavant, cela se faisait sur une MMT dans une pièce séparée à température contrôlée. Pendant de nombreuses années, les fabricants ont voulu le faire sur le plancher de production. Il est désormais possible d'avoir un système entièrement portable, sans protection, idéal pour les applications d'inspection du premier article, directement sur la machine de production », a-t-il déclaré.

Il convient que ces applications se développent dans les PME. Il a également noté que ces opérations avaient du mal à trouver de la main-d'œuvre qualifiée, ce qui nécessitait davantage d'automatisation.

ABB a également développé un système d'inspection robotique grâce à une collaboration avec NUB3D (qu'il a ensuite acquis), un innovateur de premier plan en matière de solutions numériques d'inspection 3D et de contrôle qualité. Le système clé en main se compose d'un capteur de balayage à lumière blanche 3D monté sur le bras d'un robot ABB.

Stäubli Corp. (Duncan, SC) is a robot company that uses a variety of machine vision from third-party vendors to build applications for robot vision guidance. But it also offers another use of vision systems with industrial robots that need human interaction:a virtual safety fence around robots.

As explained by Olivier Cremoux, business development manager, North America robotics for Stäubli, man/robot collaboration can be binned into five different stages. The lowest stage 1, common in most industrial robots, is no direct contact, where any interaction between man and machine is dangerous. “The robot and operator are separated by hard fences,” he said. The highest, stage 5, is where contact is desired and required, for example when a robot is hand guided by an operator to carry out or assemble a heavy tool or other simultaneous motions with a robot. There are stages in-between where some contact is desired at different levels, and where the robot often needs to stop and let the human do something. “This in-between represents 95% of collaborative applications,” he said.

In these intermediate stages, a 3D scanning vision system that scans outwards from the workcell can detect a human approaching. Within a certain distance, it signals the workcell to slow the robot down to prevent contact and possible injury. As the human approaches even closer, it stops the cell entirely. This allows the human to perform an action, such as inspection or placement, then move away, allowing the cell to automatically restart.

HNJ Solutions Inc. (Carson, CA) is an integration company founded to provide vision systems for manufacturing, including with robots, according to President Greg McEntyre. While acknowledging that vision systems are indeed becoming easier to use and install, he says there remains a class of applications where integrators like HNJ are needed. “In complex applications with multiple colors, sizes, orientations, and general uncertainty, it is important to know how cameras work and why they work to install a good system,” he said.

He emphasized how 3D cameras are expanding relevant applications, such as bin picking. “Today we are even importing the CAD model of our objects so that the vision system can understand in 3D the object it needs to pick or operate on,” he said. “Cameras give complete freedom.”

What advice might he offer, as an integrator of complex vision and robotics? “While it may not be easy as it looks, I would say just jump in,” he said. “There is so much useful hardware that vision guidance and vision applications are becoming ever more useful.” In other words, just do it.

Système de contrôle d'automatisation

- Avantages et inconvénients d'une machine à tour

- Fanuc ouvre une nouvelle installation de robotique et d'automatisation

- ABB et B&R lancent la "première solution entièrement intégrée de robotique centrée sur la machine"

- SICK présentera un webinaire sur la personnalisation de la vision artificielle

- Elementary Robotics lève 13 millions de dollars pour ses offres d'apprentissage automatique et de vision par ordinateur destinées à l'industrie

- Le rôle de la robotique et de l'automatisation dans l'industrie 4.0

- Entraînements et sécurité des machines

- Dispositifs de sécurité et considérations

- ABB Robotics :Innovation technologique et R&D robotique