Edge AI défie la technologie de mémoire

L'essor de l'IA à la périphérie s'accompagne de toute une série de nouvelles exigences pour les systèmes de mémoire. Les technologies de mémoire d'aujourd'hui peuvent-elles répondre aux exigences strictes de cette nouvelle application difficile, et que promettent les technologies de mémoire émergentes pour l'IA de pointe à long terme ?

La première chose à réaliser est qu'il n'y a pas d'application standard « edge AI » ; le bord dans son interprétation la plus large couvre tous les systèmes électroniques activés par l'IA en dehors du cloud. Cela peut inclure le « near edge », qui couvre généralement les centres de données d'entreprise et les serveurs sur site.

Plus loin se trouvent des applications telles que la vision par ordinateur pour la conduite autonome. L'équipement de passerelle pour la fabrication effectue une inférence d'IA pour vérifier les défauts des produits sur la ligne de production. Les « boîtes de bord » 5G sur les poteaux électriques analysent les flux vidéo pour les applications de ville intelligente telles que la gestion du trafic. Et l'infrastructure 5G utilise l'IA à la périphérie pour des algorithmes de formation de faisceaux complexes mais efficaces.

À la « extrême périphérie », l'IA est prise en charge dans des appareils tels que les téléphones mobiles - pensez aux filtres Snapchat - le contrôle vocal des appareils et des nœuds de capteurs IoT dans les usines effectuant la fusion de capteurs avant d'envoyer les résultats à un autre appareil passerelle.

Le rôle de la mémoire dans les systèmes d'IA de périphérie - pour stocker les poids du réseau de neurones, le code du modèle, les données d'entrée et les activations intermédiaires - est le même pour la plupart des applications d'IA. Les charges de travail doivent être accélérées pour maximiser la capacité de calcul de l'IA afin de rester efficace, de sorte que les exigences en matière de capacité et de bande passante sont généralement élevées. Cependant, les demandes spécifiques aux applications sont nombreuses et variées, et peuvent inclure la taille, la consommation d'énergie, le fonctionnement à basse tension, la fiabilité, les considérations thermiques/de refroidissement et le coût.

Centres de données de pointe

Les centres de données de périphérie sont un marché de périphérie clé. Les cas d'utilisation vont de l'imagerie médicale à la recherche et aux algorithmes financiers complexes, où la confidentialité empêche le téléchargement vers le cloud. Un autre est celui des véhicules autonomes, où la latence l'empêche.

Ces systèmes utilisent les mêmes mémoires trouvées dans les serveurs d'autres applications.

« Il est important d'utiliser une DRAM à faible latence pour une mémoire principale rapide au niveau de l'octet dans les applications où des algorithmes d'IA sont développés et entraînés », a déclaré Pekon Gupta, architecte de solutions chez Smart Modular Technologies, concepteur et développeur de produits de mémoire. « Des RDIMM ou LRDIMM haute capacité sont nécessaires pour les grands ensembles de données. Les NVDIMM sont nécessaires pour l'accélération du système — nous les utilisons pour la mise en cache d'écriture et le point de contrôle au lieu de SSD plus lents. »

Pékon Gupta

La localisation des nœuds informatiques à proximité des utilisateurs finaux est l'approche adoptée par les opérateurs de télécommunications.

"Nous constatons une tendance à rendre ces serveurs périphériques [telco] plus capables d'exécuter des algorithmes complexes", a déclaré Gupta. Par conséquent, "les fournisseurs de services ajoutent plus de mémoire et de puissance de traitement à ces serveurs de périphérie en utilisant des périphériques tels que RDIMM, LRDIMM et une mémoire persistante à haute disponibilité telle que NVDIMM."

Gupta considère Intel Optane, la mémoire non volatile 3D-Xpoint de l'entreprise dont les propriétés se situent entre DRAM et Flash, comme une bonne solution pour les applications d'IA de serveur.

"Les DIMM Optane et les NVDIMM sont utilisés comme accélérateurs d'IA", a-t-il déclaré. « Les NVDIMM offrent des capacités de hiérarchisation à très faible latence, de mise en cache, de mise en mémoire tampon d'écriture et de stockage de métadonnées pour l'accélération des applications d'IA. Les modules DIMM du centre de données Optane sont utilisés pour l'accélération de la base de données en mémoire où des centaines de gigaoctets à des téraoctets de mémoire persistante sont utilisés en combinaison avec la DRAM. Bien qu'il s'agisse de deux solutions de mémoire persistante pour les applications d'accélération AI/ML, elles ont des cas d'utilisation différents et distincts. »

Kristie Mann, directrice du marketing produit d'Intel pour Optane, a déclaré à EE Times Optane gagne des applications dans le segment de l'IA des serveurs.

Kristie Mann d'Intel

"Nos clients utilisent déjà la mémoire persistante Optane pour alimenter leurs applications d'IA aujourd'hui", a-t-elle déclaré. « Ils alimentent avec succès le commerce électronique, les moteurs de recommandation vidéo et les analyses financières en temps réel. Nous assistons à une évolution vers les applications en mémoire en raison de l'augmentation de la capacité disponible. »

Les prix élevés de la DRAM font de plus en plus d'Optane une alternative intéressante. Un serveur doté de deux processeurs Intel Xeon Scalable et d'une mémoire persistante Optane peut contenir jusqu'à 6 téraoctets de mémoire pour les applications gourmandes en données.

« La DRAM est toujours la plus populaire, mais elle a ses limites du point de vue des coûts et de la capacité », a déclaré Mann. « De nouvelles technologies de mémoire et de stockage telles que la mémoire persistante Optane et le SSD Optane [émergent] comme une alternative à la DRAM en raison de leur coût, de leur capacité et de leurs performances. Les SSD Optane sont particulièrement puissants pour la mise en cache des données HDD et NAND SSD pour alimenter en continu les données des applications d'IA. »

Optane se compare également favorablement à d'autres souvenirs émergents qui ne sont pas pleinement matures ou évolutifs aujourd'hui, a-t-elle ajouté.

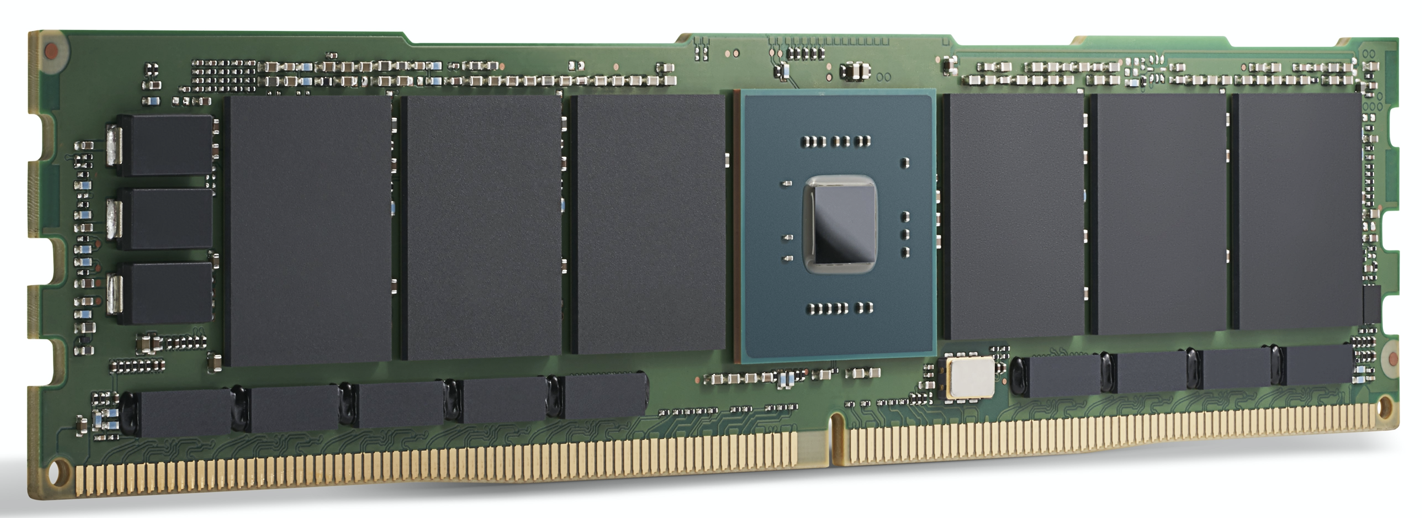

Un module Intel Optane 200 Series. Intel affirme qu'Optane est

déjà utilisé pour alimenter les applications d'IA aujourd'hui. (Source :Intel)

Accélération GPU

Pour les applications de centre de données et de serveur de périphérie haut de gamme, les accélérateurs de calcul d'IA comme les GPU gagnent du terrain. En plus de la DRAM, les choix de mémoire ici incluent GDDR, une SDRAM DDR spéciale conçue pour alimenter les GPU à large bande passante, et HBM, une technologie d'empilage de matrices relativement nouvelle qui place plusieurs matrices de mémoire dans le même package que le GPU lui-même.

Les deux sont conçus pour la bande passante mémoire extrêmement élevée requise par les applications d'IA.

Pour la formation de modèle d'IA la plus exigeante, HBM2E offre 3,6 Gbit/s et fournit une bande passante mémoire de 460 Go/s (deux piles HBM2E fournissent près de 1 To/s). C'est l'une des mémoires les plus performantes disponibles, dans la plus petite zone avec la plus faible consommation d'énergie. HBM est utilisé par le leader des GPU Nvidia dans tous ses produits de centre de données.

La GDDR6 est également utilisée pour les applications d'inférence d'IA à la périphérie, a déclaré Frank Ferro, directeur principal du marketing produit pour IP Cores chez Rambus. Ferro a déclaré que la GDDR6 peut répondre aux exigences de vitesse, de coût et de puissance des systèmes d'inférence d'IA de périphérie. Par exemple, la GDDR6 peut fournir 18 Gbit/s et fournit 72 Go/s. Avoir quatre DRAM GDDR6 fournit près de 300 Go/s de bande passante mémoire.

« La GDDR6 est utilisée pour l'inférence d'IA et les applications ADAS, a ajouté Ferro.

En comparant GDDR6 à LPDDR, l'approche de Nvidia pour la plupart des solutions de périphérie non datacenter, de Jetson AGX Xavier à Jetson Nano, Ferro a reconnu que LPDDR est adapté à l'inférence d'IA à faible coût à la périphérie ou au point de terminaison.

« La bande passante de LPDDR est limitée à 4,2 Gbps pour LPDDR4 et à 6,4 Gbps pour LPDDR5 », a-t-il déclaré. « Au fur et à mesure que les demandes de bande passante mémoire augmentent, nous verrons un nombre croissant de conceptions utilisant la GDDR6. Cet écart de bande passante mémoire contribue à stimuler la demande de GDDR6. »

Frank Ferro de Rambus

Bien qu'ils soient conçus pour s'adapter aux GPU, d'autres accélérateurs de traitement peuvent tirer parti de la bande passante de la GDDR. Ferro a présenté l'Achronix Speedster7t, un accélérateur d'IA basé sur FPGA utilisé pour l'inférence et certains entraînements bas de gamme.

« Il y a de la place pour les mémoires HBM et GDDR dans les applications d'IA de périphérie », a déclaré Ferro. HBM « continuera à être utilisé dans les applications de périphérie. Malgré tous les avantages de HBM, le coût reste élevé en raison de la technologie 3D et de la fabrication 2.5D. Compte tenu de cela, la GDDR6 est un bon compromis entre le coût et les performances, en particulier pour l'inférence d'IA dans le réseau. »

HBM est utilisé dans les ASIC d'IA de centre de données hautes performances comme l'IPU Graphcore. Bien qu'il offre des performances exceptionnelles, son prix peut être élevé pour certaines applications.

Qualcomm fait partie de ceux qui utilisent cette approche. Son Cloud AI 100 cible l'accélération de l'inférence de l'IA dans les centres de données périphériques, les « boîtes périphériques 5G », ADAS/conduite autonome et l'infrastructure 5G.

"Il était important pour nous d'utiliser une DRAM standard plutôt que quelque chose comme HBM, car nous voulons réduire la nomenclature", a déclaré Keith Kressin, directeur général de l'unité Computing and Edge Cloud de Qualcomm. « Nous voulions utiliser des composants standard que vous pouvez acheter auprès de plusieurs fournisseurs. Nous avons des clients qui veulent tout faire sur puce, et nous avons des clients qui veulent utiliser plusieurs cartes. Mais ils voulaient tous garder le coût raisonnable, et ne pas opter pour HBM ou même une mémoire plus exotique.

"En formation", a-t-il poursuivi, "vous avez de très gros modèles qui passeraient par [plusieurs puces], mais pour l'inférence [le marché du Cloud AI 100], beaucoup de modèles sont plus localisés."

Le bord éloigné

En dehors du centre de données, les systèmes d'intelligence artificielle de pointe se concentrent généralement sur l'inférence, à quelques exceptions notables près, telles que l'apprentissage fédéré et d'autres techniques de formation incrémentielle.

Certains accélérateurs d'IA pour les applications sensibles à l'alimentation utilisent de la mémoire pour le traitement de l'IA. L'inférence, qui est basée sur la multiplication matricielle multidimensionnelle, se prête aux techniques de calcul analogiques avec un réseau de cellules mémoire utilisées pour effectuer des calculs. En utilisant cette technique, les appareils de Syntiant sont conçus pour le contrôle vocal de l'électronique grand public, et les appareils de Gyrfalcon ont été conçus dans un smartphone où ils gèrent l'inférence pour les effets de caméra.

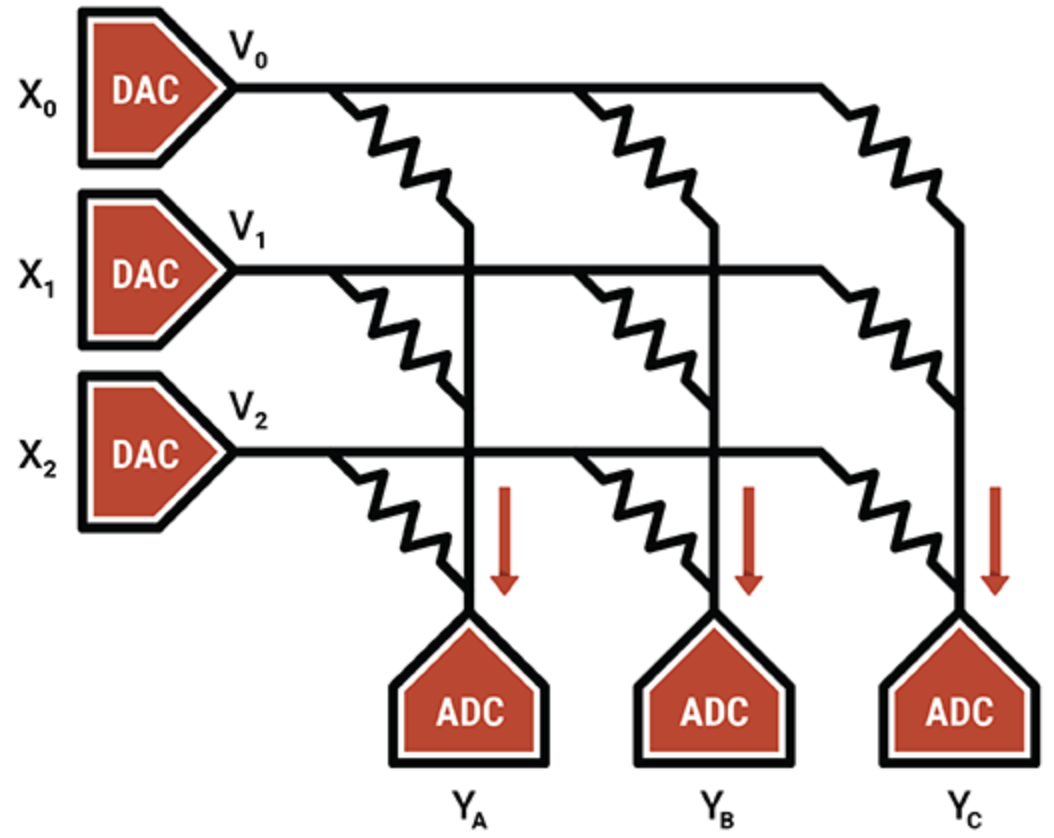

Dans un autre exemple, le spécialiste des unités de traitement intelligent Mythic utilise le fonctionnement analogique des cellules de mémoire flash pour stocker une valeur entière de 8 bits (un paramètre de poids) sur un seul transistor flash, ce qui le rend beaucoup plus dense que les autres technologies de calcul en mémoire. Le transistor flash programmé fonctionne comme une résistance variable; les entrées sont fournies sous forme de tensions et les sorties collectées sous forme de courants. Combiné avec des CAN et des DAC, le résultat est un moteur de multiplication matriciel efficace.

L'IP de Mythic réside dans les techniques de compensation et d'étalonnage qui annulent le bruit et permettent un calcul fiable sur 8 bits.

Mythic utilise un ensemble de transistors de mémoire Flash pour créer des moteurs denses de multiplication-accumulation (Source :Mythic)

Mis à part les dispositifs de calcul en mémoire, les ASIC sont populaires pour des niches de périphérie spécifiques, en particulier pour les systèmes à faible et très faible consommation. Les systèmes de mémoire pour ASIC utilisent une combinaison de plusieurs types de mémoire. La SRAM locale distribuée est la plus rapide, la plus économe en énergie, mais pas très économe en espace. Le fait d'avoir une seule SRAM en vrac sur la puce est plus efficace sur le plan de la zone, mais introduit des goulots d'étranglement des performances. La DRAM hors puce est moins chère mais consomme beaucoup plus d'énergie.

Geoff Tate, PDG de Flex Logix, a déclaré que trouver le bon équilibre entre la SRAM distribuée, la SRAM en masse et la DRAM hors puce pour son InferX X1 nécessitait une gamme de simulations de performances. L'objectif était de maximiser le débit d'inférence par dollar - en fonction de la taille de la puce, du coût du package et du nombre de DRAM utilisées.

« Le point optimal était une seule DRAM LPDDR4 x32 ; MAC 4K (7,5 TOPS à 933MHz); et environ 10 Mo de SRAM », a-t-il déclaré. « La SRAM est rapide, mais elle est chère par rapport à la DRAM. Grâce à la technologie de traitement 16 nm de TSMC, 1 Mo de SRAM prend environ 1,1 mm 2 . « Notre InferX X1 ne mesure que 54 mm 2 et en raison de notre architecture, les accès à la DRAM se chevauchent largement avec le calcul, il n'y a donc pas de compromis sur les performances. Pour les grands modèles, avoir une seule DRAM est le bon compromis, du moins avec notre architecture », a déclaré Tate.

La puce Flex Logix sera utilisée dans les applications d'inférence IA de périphérie qui nécessitent un fonctionnement en temps réel, y compris l'analyse de la vidéo en streaming avec une faible latence. Cela inclut les systèmes ADAS, l'analyse des séquences de sécurité, l'imagerie médicale et les applications d'assurance qualité/inspection.

Quel type de DRAM sera intégré à l'InferX X1 dans ces applications ?

« Nous pensons que LPDDR sera le plus populaire :une seule DRAM donne plus de 10 Go/s de bande passante… mais a suffisamment de bits pour stocker les poids/activations intermédiaires », a déclaré Tate. "Toute autre DRAM nécessiterait plus de puces et d'interfaces et il faudrait acheter plus de bits qui ne sont pas utilisés."

Y a-t-il de la place pour des technologies de mémoire émergentes ici ?

"Le coût de la plaquette augmente considérablement lors de l'utilisation de toute mémoire émergente, alors que la SRAM est" gratuite ", à l'exception de la zone silicium", a-t-il ajouté. « À mesure que l'économie évolue, le point de basculement pourrait également changer, mais ce sera plus tard sur la route. »

Souvenirs émergents

Malgré les économies d'échelle, d'autres types de mémoire offrent des possibilités futures pour les applications d'IA.

La MRAM (RAM magnéto-résistive) stocke chaque bit de données via l'orientation d'aimants contrôlés par une tension électrique appliquée. Si la tension est inférieure à celle requise pour basculer le bit, il n'y a qu'une probabilité qu'un bit bascule. Ce caractère aléatoire est indésirable, la MRAM est donc pilotée avec des tensions plus élevées pour l'empêcher. Pourtant, certaines applications d'IA peuvent tirer parti de cette stochasité inhérente (qui peut être considérée comme le processus de sélection ou de génération aléatoire de données).

Des expériences ont appliqué les capacités de stochasité de sa MRAM aux dispositifs de Gyrfalcon, une technique par laquelle la précision de tous les poids et activations est réduite à 1 bit. Ceci est utilisé pour réduire considérablement les besoins de calcul et d'alimentation pour les applications de pointe. Des compromis avec la précision sont probables, selon la façon dont le réseau est réformé. En général, les réseaux de neurones peuvent fonctionner de manière fiable malgré la précision réduite.

« Les réseaux de neurones binarisés sont uniques en ce qu'ils peuvent fonctionner de manière fiable même si la certitude qu'un nombre est -1 ou +1 est réduite », a déclaré Andy Walker, vice-président produit chez Spin Memory. « Nous avons constaté que ces BNN peuvent toujours fonctionner avec des niveaux de précision élevés, car cette certitude est réduite [en] introduisant ce qu'on appelle le « taux d'erreur sur les bits » des bits de mémoire écrits de manière incorrecte. »

Andy Walker de Spin Memory

La MRAM peut naturellement introduire des taux d'erreur sur les bits de manière contrôlée à des niveaux de tension bas, en maintenant la précision tout en réduisant encore plus les besoins en énergie. La clé est de déterminer la précision optimale à la tension la plus basse et au temps le plus court. Cela se traduit par l'efficacité énergétique la plus élevée, a déclaré Walker.

Bien que cette technique s'applique également aux réseaux de neurones de haute précision, elle est particulièrement adaptée aux BNN, car la cellule MRAM a deux états, qui correspondent aux états binaires d'un BNN.

L'utilisation de la MRAM à la périphérie est une autre application potentielle, selon Walker.

« Pour l'IA de pointe, la MRAM a la capacité de fonctionner à des tensions plus basses dans les applications où la précision des hautes performances n'est pas requise, mais les améliorations de l'efficacité énergétique et de l'endurance de la mémoire sont très importantes », a-t-il déclaré. "En outre, la non-volatilité inhérente de la MRAM permet la conservation des données sans alimentation.

Une application est une mémoire dite unifiée "où cette mémoire émergente peut agir à la fois comme un flash intégré et un remplacement SRAM, économisant de l'espace sur la puce et évitant la dissipation de puissance statique inhérente à la SRAM."

Alors que la MRAM de Spin Memory est sur le point d'être adoptée commercialement, une mise en œuvre spécifique du BNN fonctionnerait mieux sur une variante de la cellule MRAM de base. Par conséquent, il reste au stade de la recherche.

ReRAM neuromorphique

Une autre mémoire émergente pour les applications Edge AI est la ReRAM. Des recherches récentes du Politecnico Milan utilisant la technologie ReRAM d'oxyde de silicium (SiOx) de Weebit Nano se sont révélées prometteuses pour l'informatique neuromorphique. ReRAM a ajouté une dimension de plasticité au matériel de réseau neuronal ; c'est-à-dire qu'il pourrait évoluer à mesure que les conditions changent, une qualité utile dans le calcul neuromorphique.

Les réseaux de neurones actuels ne peuvent pas apprendre sans oublier les tâches sur lesquelles ils ont été formés, alors que le cerveau peut le faire assez facilement. En termes d'IA, il s'agit d'un « apprentissage non supervisé », où l'algorithme effectue une inférence sur des ensembles de données sans étiquettes, à la recherche de ses propres modèles dans les données. Le résultat final pourrait être des systèmes d'IA de pointe compatibles ReRAM qui peuvent apprendre de nouvelles tâches in situ et s'adapter à l'environnement qui les entoure.

Dans l'ensemble, les fabricants de mémoire introduisent des technologies offrant la vitesse et la bande passante requises pour les applications d'IA. Diverses mémoires, qu'elles soient sur la même puce que le calcul de l'IA, dans le même boîtier ou sur des modules séparés, sont disponibles pour s'adapter à de nombreuses applications d'IA de pointe.

Alors que la nature exacte des systèmes de mémoire pour Edge AI dépend de l'application, GDDR, HBM et Optane s'avèrent populaires pour les centres de données, tandis que LPDDR est en concurrence avec la SRAM sur puce pour les applications de point de terminaison.

Les mémoires émergentes prêtent leurs nouvelles propriétés à la recherche conçue pour faire progresser les réseaux de neurones au-delà des capacités du matériel d'aujourd'hui pour permettre de futurs systèmes économes en énergie et inspirés du cerveau.

>> Cet article a été initialement publié le notre site partenaire, EE Times.

Embarqué

- Mémoire en lecture seule (ROM)

- Microprocesseurs

- Big Data, pas Big Easy :Surmonter les nouveaux défis de la technologie de maintenance en usine

- Mémoire à changement de phase intégrée à échantillonnage ST pour microcontrôleurs automobiles

- La technologie d'application Edge profite à toutes les industries

- La 5G et Edge soulèvent de nouveaux défis en matière de cybersécurité pour 2021

- 4 conseils et défis pour une meilleure gestion des actifs IIoT

- 3 excellents exemples de technologie de fabrication avancée de pointe

- Technologie de mouvement linéaire