Test de la signalisation optique à modulation directe 800G

Les systèmes de communications optiques ont joué un rôle clé dans la construction de notre infrastructure d'information. De nombreux centres de données utilisés pour stocker et transmettre des informations disposent de kilomètres de fibre et de milliers de récepteurs laser/photodétecteurs pour envoyer et recevoir des informations sur la fibre. Il y a une pression commerciale incessante pour augmenter la capacité et le processus de développement de nouveaux systèmes qui fonctionnent à des débits de données plus élevés se poursuit. Il ne s'agit pas simplement de concevoir des systèmes qui déplacent plus d'informations. Le coût de ces systèmes doit baisser. Les centres de données sont parfois décrits en termes d'acres et de mégawatts, ce qui indique que la puissance nécessaire pour faire fonctionner le centre de données est énorme. Il existe une forte motivation pour trouver des moyens non seulement de fonctionner à des capacités plus élevées, mais de le faire tout en utilisant moins d'énergie.

Le système de communication optique de base comprend un émetteur laser qui convertit les données électriques en lumière modulée, une fibre optique et un récepteur à photodiode pour reconvertir la lumière modulée en un signal électrique. La conception du système de communication optique est compliquée par le fait que dans l'environnement du centre de données, il est rarement exigé que la liaison optique soit fabriquée par un seul fournisseur. L'émetteur, la fibre et le récepteur seront probablement produits par trois sociétés différentes. Ce concept, connu sous le nom d'interopérabilité, donne au concepteur du centre de données une flexibilité et facilite la concurrence entre les fournisseurs, ce qui conduit à plus d'innovation et à des coûts réduits. L'inconvénient est que la conception du système et la spécification des composants de ce système deviennent plus complexes.

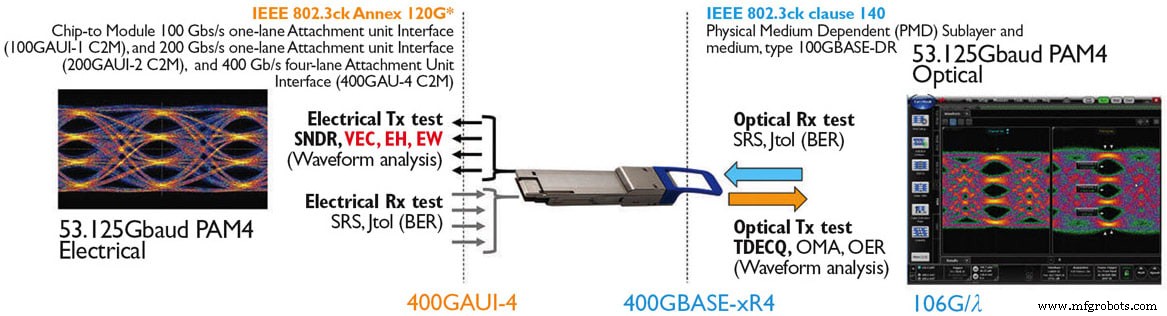

Une organisation de normalisation telle que IEEE 802.3 offre un forum public pour définir les systèmes de communication. Les réunions sont ouvertes à tous et réunissent les concepteurs de centres de données, ainsi que les fabricants d'équipements de réseau, d'émetteurs-récepteurs et de fibre. Étant donné que la norme définira la performance et la manière dont elle est vérifiée, les entreprises de test et de mesure y participent également. L'un des résultats essentiels du groupe de normalisation est un ensemble de spécifications pour les émetteurs et un ensemble de spécifications pour les récepteurs. Encore une fois, les deux ensembles existent pour promouvoir l'interopérabilité. Plus récemment, le groupe de travail IEEE 802.3cu a publié le projet de document de 100 Gbit/s par longueur d'onde, qui sera la spécification clé pour les futures interconnexions à base de fibre.

Les spécifications commencent généralement par le récepteur, où les limites de la puissance du signal détermineront la fiabilité avec laquelle un photodétecteur peut convertir le signal optique en données électriques. Si le niveau du signal tombe en dessous d'une sensibilité recommandée, le récepteur commettra trop d'erreurs, qui sont généralement considérées comme des erreurs sur les bits. Ce seuil est appelé limite de sensibilité du récepteur.

Il y aura généralement un objectif pour la distance que le signal doit parcourir, peut-être aussi courte que 100 mètres ou aussi longue que 40 kilomètres. L'atténuation causée par la fibre est bien connue, donc en partant du récepteur, en tenant compte de la perte attendue de la fibre, on définit ensuite le niveau de puissance de signal minimum qu'un émetteur doit produire. En réalité, c'est plus compliqué car il existe une variété de mécanismes qui peuvent amener un système à générer des erreurs sur les bits au-delà du simple fait que la puissance tombe en dessous de la limite de sensibilité du récepteur.

Du point de vue d'un récepteur, deux lasers fonctionnant au même niveau de puissance peuvent générer des signaux très différents. Les systèmes à la pointe de la technologie fonctionnent aujourd'hui à plus de 50 GBaud (PAM4). C'est-à-dire que la lumière doit être allumée et éteinte au niveau de l'émetteur jusqu'à 50 milliards de fois par seconde. Le récepteur doit détecter que la lumière est allumée ou éteinte, et un émetteur de qualité inférieure peut être lent. Le laser peut générer un signal qui n'est pas stable lorsque le récepteur prend une décision. Ainsi, la qualité du signal laser doit atteindre un niveau minimum. De même, nous ne pouvons pas nous attendre à avoir des émetteurs parfaits, les récepteurs doivent donc avoir une certaine tolérance pour les signaux d'entrée non idéaux. Cela conduit à certaines exigences importantes pour les émetteurs et les récepteurs :

Évaluation de l'émetteur optique

-

Amplitude de modulation optique (OMA) :la différence entre les niveaux logiques de l'émetteur.

-

Bruit d'intensité relative (RIN) :mesure de la quantité de bruit générée par un émetteur.

-

Dispersion de l'émetteur et fermeture des yeux :TDEC ou TDECQ (pour la modulation PAM4) est une mesure statistique de la qualité du signal, indiquant la probabilité que le signal génère des erreurs dans le récepteur (Figure 1).

-

Overshoot/Undershoot :nouvelles métriques récemment définies dans IEEE 802.3cu pour protéger les récepteurs des transitoires sévères sur le signal d'entrée.

Signaux de récepteur optique altérés

Sensibilité du récepteur sous contrainte (SRS) :le taux d'erreur sur les bits ou le taux de perte de trame attendu en dessous du niveau attendu lorsque le signal entrant dans le récepteur est le pire des cas de signal attendu de l'émetteur (et du canal).

Des instruments de test ont été développés pour offrir des dégradations optiques de qualité instrumentale (à des cibles TDECQ, ER et OMA spécifiques) pour les tests de récepteurs stressés. La figure 2 illustre un signal SRS optique typique qui serait généré à des fins de test.

Les émetteurs sont généralement testés avec un oscilloscope analyseur de communications numériques spécialisé. Ces instruments ont des récepteurs de référence optique intégrés et un micrologiciel pour exécuter les mesures requises par ces normes. De même, pour les récepteurs, des systèmes de test SRS (Figure 3), comprenant un signal "altéré" calibré et un testeur de taux d'erreur sur les bits (BERT), sont disponibles pour vérifier la conformité aux normes.

Les performances de liaison à 100 Gbit/s, qu'elles soient électriques ou optiques, fonctionnent toutes deux à des taux d'erreur binaire plus élevés que leurs homologues à vitesse inférieure de 25 ou 50 Gbit/s. Les interfaces 100 Gbit/s actuelles fonctionnent à des taux d'erreur de liaison natifs aussi élevés que 2E-4 BER et s'appuient sur des techniques modernes de correction d'erreur directe Reed-Solomon (RS-FEC) pour corriger les erreurs aléatoires et isolées sur les bits qui se produisent naturellement lors de la transmission.

Le codage d'erreur directe est un processus qui démarre sur les données au niveau de la sous-couche de codage physique (PCS) avant la transition des données vers la pièce jointe de support physique (PMA). Cette interface PCS/PMA gère les contributions au codage des erreurs de données, à l'entrelacement, au brouillage et à l'alignement. Ce système de codage PCS/PMA pose des problèmes d'analyse du taux d'erreur, car le processus d'observation de la cause profonde générant l'erreur physique sur les bits est désormais obscurci par une quantité considérable de circuits de correction d'erreur numérique et d'entrelacement. Le désir d'examiner les erreurs physiques dans une transmission optique qui conduit à des trames de données irrécupérables est un processus complexe, et celui que les fournisseurs d'instruments de test font activement progresser aujourd'hui. Des outils spécialisés tels que les systèmes d'analyse multiport Layer1 BERT et KP4 FEC font désormais partie intégrante de la tolérance du récepteur et des outils de débogage généraux compatibles FEC (Figure 4).

L'écart PCS/PMA qui existe entre un signal optique corrigé FEC et sa transmission physique brute réelle peut être comblé avec le système de test de récepteur compatible FEC 400G de Keysight, qui analyse les flux de données codés FEC et peut diriger un oscilloscope pour localiser (déclencher) le signal physique interface optique aux emplacements où des erreurs se produisent et offre aux concepteurs de systèmes un outil pour la première fois qui relie l'analyse des erreurs post-FEC à l'analyse et à la visualisation de la transmission physique côte à côte.

Résumé

Actuellement, les systèmes de communication de données à modulation directe de la plus haute capacité fonctionnent à 400 Gbps. Ces systèmes ont plusieurs voies de 100 Gbps, utilisant soit quatre émetteurs et quatre fibres, soit quatre émetteurs de longueur d'onde et une seule fibre. Les liaisons 800 Gbit/s de première génération seront des systèmes 400 Gbit/s mis à l'échelle 2× grâce à des connecteurs à plus haute densité tels que les interconnexions QSFP-DD et OSFP. Dans ce scénario, avec juste plus de voies de 100 Gbps à agréger à 800 Gbps, les spécifications et les méthodes de test resteront similaires à ce qu'elles sont pour les systèmes 400 Gbps. Les liaisons natives × 4 voies à 800 Gbit/s dépendront des progrès des spécifications électriques et optiques qui sont actuellement en cours. Cette prochaine classe de vitesse à 800 Gbit/s passera très probablement à une vitesse native de 200 Gbit/s par voie, à la fois électriquement et optiquement, tout en respectant les besoins importants du marché en matière de réduction de la consommation et des coûts énergétiques globaux.

Lorsque la transmission à voie unique de 200 Gbps sera atteinte, les méthodes et techniques de test de 100 Gbps seront probablement fortement exploitées, cependant, le domaine de 200 Gbps utilisera probablement des avancées dans les méthodes de modulation, car l'accent est mis sur l'efficacité de transmission accrue et la gestion des goulots d'étranglement connus de la bande passante sont des points de pression clés sur cette industrie. Les partenaires de mesure de Keysight contribuent intégralement à ces efforts de normalisation de pointe pour garantir que des solutions de test efficaces continuent d'être disponibles à mesure que ces technologies évoluent vers 800 Gbit/s et 1,6 Tbit/s pour les architectures de centres de données de nouvelle génération.

Cet article a été rédigé par Greg D. Le Cheminant, spécialiste des applications de mesure, analyse des communications numériques, solutions d'infrastructure Internet ; et John Calvin, planificateur stratégique et responsable de la technologie Datacom, IP Wireline Solutions ; Keysight Technologies (Santa Rosa, Californie). Pour plus d'informations, visitez ici .

Capteur

- Qu'est-ce qu'un capteur radar :fonctionnement et ses applications

- Intégrité du signal et PCB

- Tester des capteurs dans le brouillard pour rendre les futurs transports plus sûrs

- Le biocapteur optique détecte les toxines

- Un amplificateur unique pourrait changer la communication optique

- Spectroscopie à l'aide d'un microscope optique

- Communications radio basées sur Atom

- Antennes optiques multiplexées

- Oscillateur à cristal CMOS Rad-Hard