Réseau de prédiction de métamatériaux avec résonateur à anneau fendu basé sur l'apprentissage en profondeur

Résumé

L'introduction des « métamatériaux » a eu un impact profond sur plusieurs domaines, dont l'électromagnétique. Cependant, la conception de la structure d'un métamatériau à la demande reste un processus extrêmement long. En tant que méthode d'apprentissage automatique efficace, l'apprentissage en profondeur a été largement utilisé pour la classification et la régression des données ces dernières années et a en fait montré de bonnes performances de généralisation. Nous avons construit un réseau de neurones profond pour la conception à la demande. Avec la réflectance requise en entrée, les paramètres de la structure sont automatiquement calculés puis sortis pour atteindre l'objectif de la conception à la demande. Notre réseau a atteint de faibles erreurs quadratiques moyennes (MSE), avec une MSE de 0,005 à la fois sur les ensembles d'apprentissage et de test. Les résultats indiquent qu'en utilisant l'apprentissage en profondeur pour former les données, le modèle formé peut guider plus précisément la conception de la structure, accélérant ainsi le processus de conception. Par rapport au processus de conception traditionnel, l'utilisation de l'apprentissage en profondeur pour guider la conception de métamatériaux peut atteindre des objectifs plus rapides, plus précis et plus pratiques.

Introduction

La nano-optique est un sujet interdisciplinaire de la nanotechnologie et de l'optique. Ces dernières années, en concevant constamment des structures avec différentes tailles de sous-longueurs d'onde afin d'obtenir des interactions spéciales avec la lumière incidente, les scientifiques ont réussi à manipuler certaines caractéristiques de transmission de la lumière [1,2,3]. Depuis que les métamatériaux ont été proposés, ils ont attiré l'attention de nombreux chercheurs dans ce domaine, et simultanément leurs études théoriques connexes [4, 5], processus [6, 7] et recherche appliquée [8] progressent tous à la même vitesse. De nombreuses fonctions particulières ont été réalisées, notamment l'imagerie holographique, l'absorption parfaite [9] et les lentilles plates [10]. En raison du développement rapide de la technologie térahertz et de ses caractéristiques uniques, elle est également devenue un sujet de recherche populaire dans le domaine des métamatériaux ces dernières années [11,12,13].

Bien que l'application des métamatériaux soit très large, la méthode de conception traditionnelle nécessite que le concepteur effectue à plusieurs reprises des calculs numériques complexes sur la structure en cours de conception. Ce processus consomme énormément de temps et de ressources informatiques. Par conséquent, il est urgent de trouver de nouvelles façons de simplifier ou même de remplacer les méthodes de conception traditionnelles.

En tant que domaine interdisciplinaire, l'apprentissage automatique couvre de nombreuses disciplines, notamment les sciences de la vie, l'informatique et la psychologie. Le principe de base de l'apprentissage automatique peut être simplement décrit comme l'utilisation d'algorithmes informatiques pour obtenir la corrélation entre une grande quantité de données ou pour prédire les règles entre des données similaires et enfin atteindre l'objectif de classification ou de régression. Jusqu'à présent, de nombreux algorithmes d'apprentissage automatique ont été appliqués à la désignation de métamatériaux et ont obtenu des résultats significatifs, notamment des algorithmes génétiques [14], des algorithmes de régression linéaire [15] et des réseaux de neurones peu profonds. À mesure que la structure devient de plus en plus complexe et que les changements dans la structure deviennent plus diversifiés, les problèmes nécessiteront plus de temps pour être résolus. Dans le même temps, la nature hautement non linéaire des problèmes rend difficile pour les algorithmes d'apprentissage automatique simples d'obtenir des prédictions précises. De plus, pour concevoir une structure de métamatériau adaptée à un effet électromagnétique spécifique, les concepteurs doivent essayer d'effectuer des calculs numériques complexes sur la structure. Ces processus consommeront énormément de temps et de ressources informatiques.

En tant que l'un des algorithmes les plus remarquables dans le domaine de l'apprentissage automatique, l'apprentissage en profondeur a réalisé des réalisations de renommée mondiale dans divers domaines connexes tels que la vision par ordinateur [16], l'extraction de caractéristiques [17] et le traitement du langage naturel [18]. Dans le même temps, les succès dans d'autres domaines non liés à l'informatique sont nombreux, y compris de nombreuses disciplines fondamentales telles que les sciences de la vie, la chimie [19] et la physique [20] [21]. Par conséquent, l'application de l'apprentissage en profondeur à la conception de métamatériaux est également une direction de recherche brûlante à l'heure actuelle, et de nombreux travaux remarquables sont apparus [22,23,24].

Inspiré par l'apprentissage en profondeur, cet article rapporte une étude utilisant un algorithme d'apprentissage automatique basé sur un réseau de neurones profonds pour prédire la structure du résonateur en anneau fendu (SRR) afin d'atteindre l'objectif de conception à la demande. De plus, le réseau direct et le réseau inverse sont formés séparément de manière innovante, ce qui non seulement peut améliorer la précision du réseau, mais peut également réaliser différentes fonctions grâce à une combinaison flexible. Les résultats montrent que la méthode peut atteindre une MSE de 0,0058 et 0,0055 sur l'ensemble d'apprentissage et l'ensemble de validation, respectivement, et affiche une bonne robustesse et une bonne généralisation. Avec le modèle entraîné guidant la conception des structures en métamatériaux, le cycle de conception peut être raccourci à des jours, voire des heures, et l'amélioration de l'efficacité est évidente. De plus, cette méthode a également une bonne évolutivité et ne nécessite que de modifier les données de l'ensemble d'apprentissage pour concevoir différentes entrées ou différentes structures à la demande.

Théorie et méthode

Modèle COMSOL

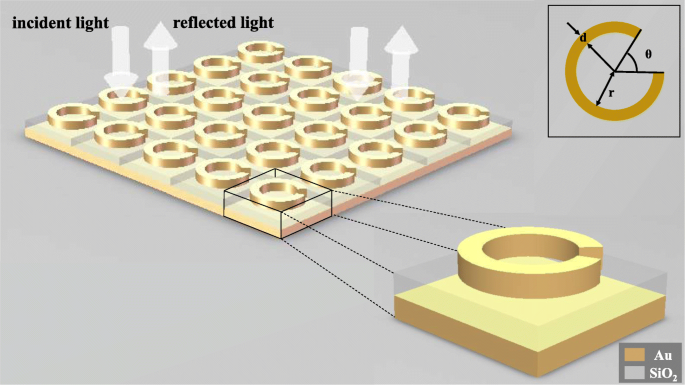

Afin de montrer que l'apprentissage profond peut être appliqué à la conception inverse de structures en métamatériaux, nous avons modélisé une structure SRR à trois couches constituée d'un anneau en or, d'un fond en silice et d'un fond en or pour observer sa réponse électromagnétique sous l'action de la lumière incidente. Comme le montre la Fig. 1, l'angle d'ouverture θ de la bague en or, le rayon intérieur r de l'anneau, et la largeur de trait d de l'anneau sont choisis comme variables indépendantes de cette structure. Lorsqu'un faisceau de lumière polarisée linéairement pénètre normalement dans les métamatériaux, les courbes de longueur d'onde-réflectance sous différentes structures sont obtenues en modifiant les variables structurelles. L'épaisseur de l'anneau Au est de 30 nm, du fond de SiO2 est de 100 nm, et du fond de Au est de 50 nm, et la taille des méta-atomes est de 200 nm par 200 nm.

Schéma de principe de la structure. La métasurface entière est composée de méta-atomes disposés à plusieurs reprises dans deux directions, et la lumière polarisée linéairement est incidente perpendiculairement à la métasurface. Chaque méta-atome est composé d'un anneau en or, d'un fond en silice et d'un fond en or dans l'ordre de haut en bas. L'anneau en or supérieur contient trois paramètres structurels, à savoir la largeur de ligne d , l'angle d'ouverture θ , et le rayon de la bague intérieure r

Utilisez COMSOL Multiphysics 5.4 [25] pour la modélisation, choisissez la dimension spatiale tridimensionnelle, choisissez l'optique ≥ l'optique des ondes ≥ le domaine de fréquence des ondes électromagnétiques (ewfd) pour le champ physique et sélectionnez le domaine de longueur d'onde pour la recherche. Créez le modèle ci-dessus en géométrie. Le matériau de chaque pièce et son indice de réfraction sont définis dans l'ordre dans le matériau, et les ports et les conditions périodiques sont ajoutés dans le domaine fréquentiel des ondes électromagnétiques.

Créer un modèle de réseau de neurones d'apprentissage en profondeur

Nous avons construit un réseau inverse et un réseau direct pour la structure métamatérielle. Le réseau inverse peut prédire les paramètres structurels du SRR à partir des deux ensembles donnés de courbes de longueur d'onde-réflectance avec différentes directions de polarisation. Le réseau direct peut prédire les courbes de longueur d'onde-réflectance dans deux directions de polarisation par les paramètres structurels donnés. La fonction du réseau inverse est le corps principal de la fonction de prédiction. Le rôle du réseau direct est de vérifier les résultats de prédiction du réseau inverse pour observer si les résultats de prédiction répondent à la réponse électromagnétique requise.

Utilisez eclipse 2019 comme plate-forme de développement, python3.7 comme langage de programmation et TensorFlow 1.12.0 comme framework de développement.

Les deux réseaux sont entraînés séparément pour éviter que les résultats d'entraînement de chaque réseau ne soient affectés par l'erreur de l'autre réseau, ce qui garantit ainsi la précision respective des deux réseaux.

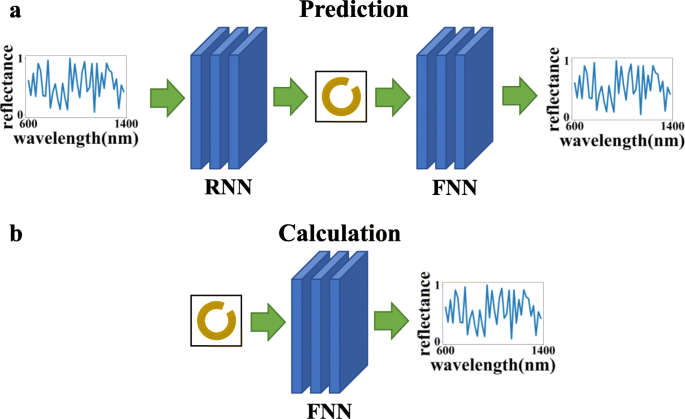

Comme le montre la figure 2, un autre avantage de l'apprentissage séparé des deux réseaux est qu'ils peuvent être utilisés à des fins différentes via différentes séquences de connexion :(a) réseau inverse + réseau direct, qui peut utiliser la courbe de longueur d'onde-réflectance donnée pour calculer le paramètres de structure, faire des prédictions et vérifier si les résultats de prédiction répondent aux besoins, et (b) l'utilisation du seul réseau de transfert peut simplifier le processus de calcul de la méthode de calcul numérique et réduire le temps de calcul.

Dans cette figure, FNN fait référence au réseau de neurones direct et RNN au réseau de neurones inverse. Le graphique du haut (a ) indique que les deux réseaux peuvent être connectés pour obtenir l'effet de prédiction et de vérification, et le graphique du bas (b ) indique que seul le réseau de réponse directe peut être utilisé pour calculer la réponse optique

Il convient de noter que le processus de saisie et d'obtention des résultats du modèle entraîné à l'aide de la méthode d'apprentissage en profondeur prend un temps extrêmement court. Et chaque fois que de nouvelles données sont obtenues par simulation ou expérimentation, le modèle peut être utilisé pour une formation complémentaire. Des études ont montré qu'avec l'augmentation continue des données d'entraînement, la précision du modèle deviendra de plus en plus élevée et les performances de généralisation de mieux en mieux [26].

Les paramètres de la structure sont de multiples ensembles de valeurs propres continues, qui appartiennent au problème de régression. Ces dernières années, les réseaux entièrement connectés ont été au centre des réseaux d'apprentissage en profondeur sur les problèmes de régression et ont montré les caractéristiques d'une fiabilité élevée, d'un débit de données important et d'une faible latence. Faire quelques ajustements sur un réseau entièrement connecté permettra au réseau de mieux prédire la structure.

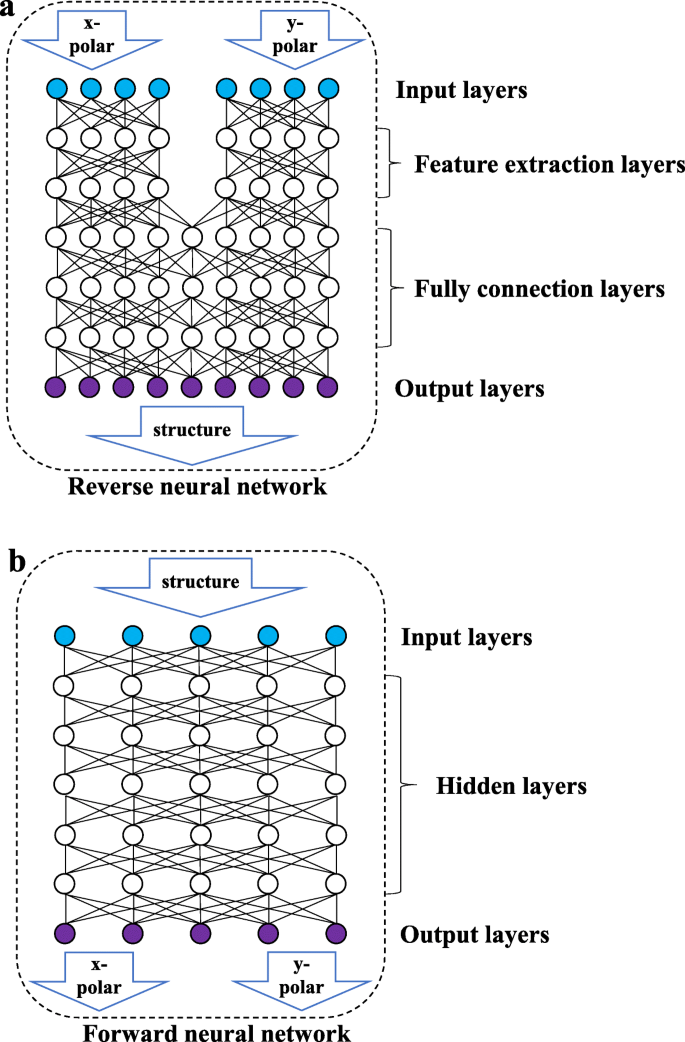

Comme le montre la figure 3b, le réseau aller est un réseau entièrement connecté dans lequel tous les nœuds des deux couches adjacentes sont connectés les uns aux autres. Les données d'entrée sont le paramètre structurel et la sortie est la courbe de longueur d'onde-réflectance des deux directions de polarisation. Comme le montre la figure 3a, le réseau inverse se compose d'une couche d'extraction de caractéristiques (couche FE) et d'une couche entièrement connectée (couche FC). La couche FE comprend deux ensembles de réseaux entièrement connectés qui ne sont pas connectés les uns aux autres et traite les courbes de longueur d'onde-réflectance de la lumière polarisée linéairement dans les deux directions pour extraire certaines caractéristiques des données d'entrée. La couche FC apprendra les caractéristiques extraites et produira les paramètres structurels. En raison des caractéristiques de cohésion élevée et de faible couplage entre les courbes de longueur d'onde-réflectance dans différents états de polarisation, séparer les entrées de deux ensembles de données de lumière polarisée dans des directions différentes peut empêcher le réseau d'être perturbé par la normalisation des données pendant le processus d'extraction des données. Le réseau de transfert n'implique pas plusieurs ensembles d'entrées et n'a pas besoin de prendre en compte les interférences mutuelles entre les données, il n'a donc pas de couche d'extraction de caractéristiques.

Schéma de principe de la structure du réseau. La figure ci-dessus montre le réseau inversé. Le réseau inverse se compose d'une couche d'entrée, d'une couche d'extraction de caractéristiques, d'une couche entièrement connectée et d'une couche de sortie. La figure suivante montre le réseau de transfert, qui se compose d'une couche d'entrée, d'une couche cachée et d'une couche de sortie

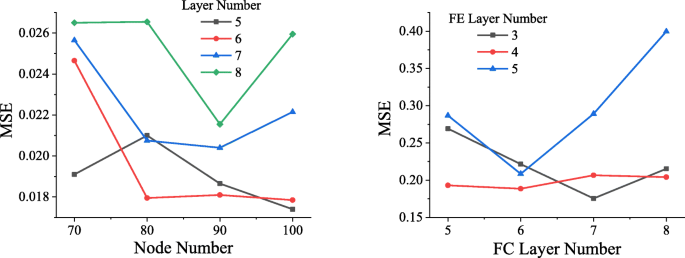

Afin de déterminer la structure de réseau optimale, des réseaux de différentes structures sont entraînés à l'aide du même ensemble de données. Comme le montre la figure 4, après que les données aient connu 50 époques (lorsque toutes les données ont subi un apprentissage complet, cela s'appelle une époque), le MSE atteint par le réseau avancé de différentes structures. Comme on peut le voir sur l'image de gauche de la figure 4, lorsque le réseau direct contient 5 couches cachées, chaque couche contenant 100 nœuds, le MSE le plus bas atteint est d'environ 0,0174, donc le réseau direct de cette structure sera sélectionné.

Comparaison des structures de réseau. Dans la figure de gauche, l'axe horizontal représente le nombre de nœuds dans chaque couche, l'axe vertical représente MSE et le noir, le rouge, le bleu et le vert représentent la situation lorsque la couche cachée contient 5, 6, 7 et 8 couches, respectivement. Dans la figure de droite, l'axe horizontal indique le nombre de couches dans la couche entièrement connectée, l'axe vertical indique MSE et les lignes noires, rouges et bleues indiquent la situation lorsque la couche FE comprend 3, 4 et 5 , respectivement

De même, différents réseaux de réseaux inversés ont été entraînés et le volume d'entraînement était toujours fixé à 50 époques. Le résultat est illustré dans la figure de droite de la figure 4. Lorsque le nombre de couches FC est 7 et le nombre de couches FE est 3, le réseau atteint le MSE le plus bas, qui est d'environ 0,1756.

Nous avons constaté qu'un plus grand nombre de couches de réseau produira un phénomène d'explosion de gradient, ce qui entraînera l'échec de la convergence du réseau, et la perte est infinie, elle n'est donc pas répertoriée dans la figure.

Prétraitement des données

Afin de former un réseau direct plus fiable, les données de réflectance sont redivisées et cousues avec la réfractivité de Au et SiO2 correspondant à chaque fréquence. Les données rassemblées sont ensuite normalisées et entrées dans le réseau de transfert, ce qui peut grandement améliorer la précision du réseau de transfert.

Afin de garantir que les données avec des valeurs plus élevées n'auront pas un impact plus important sur le réseau que les données avec des valeurs plus petites, les données d'entrée doivent être normalisées pour que chaque colonne de données soit conforme à la distribution normale standard (la valeur moyenne est 0, la variance est 1), puis les données traitées x peut être exprimé comme suit :

$$ x=\frac{\left({x}_0\hbox{-} \mu \right)}{\sigma } $$ (1)Dans l'expression, x 0 est les données d'origine de l'échantillon, μ la moyenne de l'échantillon, et σ l'écart type de l'échantillon. Si les données d'entrée ne sont pas redivisées, la réflectance sera déformée après la normalisation, ce qui réduira la précision du réseau. Les données redivisées n'affecteront pas leur distribution en raison de la normalisation.

Méthode de réseau de neurones

Le principe du réseau de neurones est de construire un grand nombre de neurones (nœuds) en imitant la façon dont le cerveau humain fonctionne et apprend [27]. Les neurones sont connectés les uns aux autres et la sortie est ajustée en ajustant le poids de connexion. La sortie du j Le nœud d'une couche peut être exprimé comme suit :

$$ {y}_j=\frac{\sum \limits_{i=1}^nf\left({w}_i{x}_i+{b}_j\right)}{n} $$ (2)f est la fonction d'activation, w i est le poids de connexion des i de la couche précédente ème nœud connecté au j ème nœud, x i est la sortie du i ème nœud de la couche précédente, b j est le terme de biais de ce nœud, et n est le nombre de nœuds de la couche précédente connectés au j ème nœud.

Choix d'une fonction d'activation

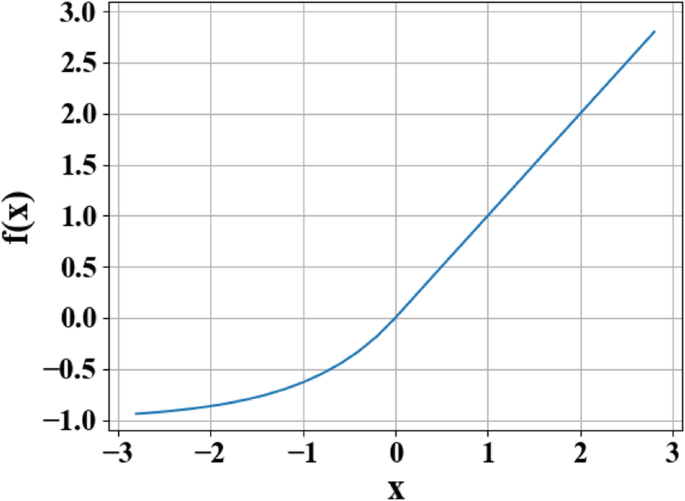

Afin de répondre à la non-linéarité élevée du problème inverse, la fonction ELU [28] est utilisée comme fonction d'activation de chaque couche de neurones [28]. La sortie f (x ) de la fonction ELU peut être exprimé par morceaux comme suit :

$$ f(x)=\left\{\begin{array}{c}x\\ {}\alpha \left({e}^x-1\right)\end{array}\right.{\displaystyle \begin{array}{c},\\ {},\end{array}}{\displaystyle \begin{array}{c}x\ge 0\\ {}x<0\end{array}} $$ (3)Dans cette fonction, x est l'entrée d'origine et la valeur du paramètre pour α va de 0 à 1.

La raison de l'utilisation de la fonction d'activation est que la fonction d'activation modifie la capacité d'expression non linéaire de chaque couche du réseau, améliorant ainsi la capacité d'ajustement non linéaire globale du réseau. Comme le montre la figure 5, la fonction ELU combine les avantages des fonctions d'activation du sigmoïde et de l'unité linéaire rectifiée (ReLU). Lorsque x <0, il a une meilleure saturation douce, ce qui rend le réseau plus robuste aux changements d'entrée et au bruit. Lorsque x> 0, il n'y a pas de saturation, ce qui est utile pour pallier la disparition du gradient du réseau. La caractéristique selon laquelle la valeur moyenne de l'ELU est proche de 1 peut faciliter l'ajustement du réseau. Le résultat prouve qu'en utilisant ELU comme fonction d'activation du deep learning, le réseau de neurones améliore considérablement la robustesse du réseau.

Courbe de fonction des unités linéaires exponentielles (ELU). Dans la figure, x représente l'entrée d'origine, et f (x ) représente la sortie de la fonction

Schéma d'initialisation du poids

La méthode d'initialisation du poids du réseau de chaque couche détermine la vitesse de l'ajustement du réseau et détermine même si le réseau peut s'adapter ou non. L'initialisation de la mise à l'échelle de la variance est basée sur la quantité de données d'entrée à chaque couche et extrait les poids d'une distribution normale tronquée centrée sur 0, de sorte que la variance peut être réduite à une certaine plage, puis les données peuvent être réparties plus profondément sur le réseau [29 ]. Sur cette structure de réseau, l'utilisation de l'initialisation de la mise à l'échelle de la variance peut accélérer considérablement la vitesse de convergence du réseau.

Solution de sur-aménagement

En raison de données insuffisantes, le réseau produira un certain surapprentissage. Avec un surapprentissage réduit, le réseau peut avoir de bonnes performances de généralisation sur des données en dehors de l'ensemble d'apprentissage. La régularisation L2 (également appelée poids-déclin dans les problèmes de régression) est utilisée pour traiter le poids w . La sortie régularisée L peut être exprimé comme suit :

$$ L={L}_0+\frac{\lambda }{2n}\sum {w}^2 $$ (4)Dans l'éq. (4), L 0 représente la fonction de perte d'origine, et un terme de régularisation \( \frac{\lambda }{2n}\sum {w}^2 \) est ajouté sur cette base, où λ représente le coefficient de régularisation, n le débit de données, et w le poids. Une fois le terme de régularisation ajouté, la valeur du poids w a tendance à diminuer globalement, et l'occurrence de valeurs excessives peut être évitée, donc w est aussi appelé atténuation de poids. La régularisation L2 peut réduire le poids pour éviter une forte pente de la courbe ajustée, atténuant ainsi efficacement le phénomène de surajustement du réseau et aidant à converger.

Sur cette base, la méthode du décrochage est également utilisée. Cette méthode peut être visuellement considérée comme « masquant » une certaine échelle de nœuds de réseau pour chaque entraînement, et masquant différents nœuds au cours de chaque entraînement, pour atteindre l'objectif de former plusieurs « réseaux partiels ». Et grâce à la formation, la plupart des « réseaux partiels » peuvent représenter avec précision les cibles, et les résultats de tous les « réseaux partiels » peuvent être triés pour obtenir la solution des cibles.

L'utilisation des méthodes de régularisation et d'abandon L2 mentionnées ci-dessus peut non seulement atténuer efficacement la faible généralisation causée par des données insuffisantes, mais également réduire l'impact d'une petite quantité de données erronées dans l'ensemble de données sur les résultats de l'entraînement.

Sur cette structure de réseau et ce jeu de données, avec décrochage =0,2 et coefficient de régularisation L2 λ =0,0001, le réseau peut obtenir une précision similaire sur l'ensemble d'apprentissage et l'ensemble de test, obtenant ainsi une performance de généralisation élevée.

Résultat et discussion

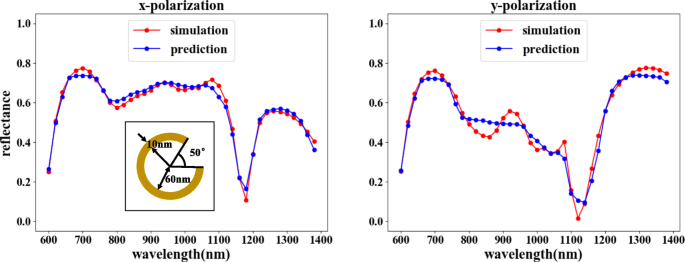

Après la formation, notre réseau direct peut atteindre un degré élevé d'ajustement, avec un MSE de 0,0015, ce qui montre que la sortie est très similaire aux résultats de la simulation, comme le montre la figure 6. Cela garantit également que lors de la formation du réseau inverse, le les résultats du réseau inversé peuvent être vérifiés de manière fiable.

Résultats de la formation avancée en réseau. Les paramètres structurels correspondants sont θ =50°, r =60 nm, et d =10 nm. Sur la figure, l'axe horizontal représente la longueur d'onde de la lumière incidente, l'axe vertical représente la réflectivité, la ligne rouge représente le résultat de la simulation COMSOL et la ligne bleue représente le résultat de l'apprentissage du réseau. La figure de gauche montre la courbe de réflectivité correspondant au x -entrée polarisée, et la figure de droite montre la courbe de réflectivité correspondant au y -entrée polarisée

Enfin, nous allons générer deux modèles à partir du réseau appris et connecter les deux modèles pour réaliser la fonction de prédiction.

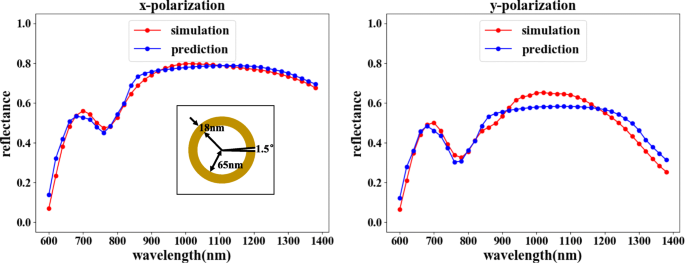

La fonction de prédiction peut choisir la combinaison représentée sur la figure 2a. Le réseau inverse prédit la structure correspondante en fonction de la courbe de longueur d'onde-réflectance requise, et le réseau direct vérifie la réponse optique de la structure. Comme le montre la figure 7, en comparant la réflectance vérifiée à la réflectance d'entrée, les caractéristiques de réflectance de la lumière incidente dans les deux directions de polarisation sont fondamentalement cohérentes. Bien qu'une inadéquation mineure de la réflectance soit observable pour certaines valeurs de longueur d'onde, la tendance globale d'appariement est clairement irréfutable, car les erreurs se situent bien dans une plage acceptable.

Le réseau inverse suivi d'un réseau aller peut atteindre l'objectif de prédiction. Sur la figure, l'axe horizontal représente la longueur d'onde de la lumière incidente, l'axe vertical représente la réflectivité, la ligne rouge représente le résultat de la simulation COMSOL et la ligne bleue représente le résultat de l'apprentissage du réseau. La figure de gauche montre la courbe de réflectivité correspondant au x -entrée polarisée, et la figure de droite montre la courbe de réflectivité correspondant au y -entrée polarisée. Les résultats prédits pour la courbe longueur d'onde-réflectance d'entrée sont θ =1,5°, r =65 nm, et d =18 nm

Conclusion

Dans cet article, nous avons présenté notre réseau d'apprentissage en profondeur conçu, capable de créer divers effets en utilisant des combinaisons flexibles de configurations de réseau. Notre réseau inverse conçu peut prédire la structure requise à l'aide de la courbe de longueur d'onde-réfraction d'entrée, ce qui peut réduire considérablement le temps nécessaire pour résoudre le problème inverse et répondre à différents besoins en utilisant des combinaisons flexibles. Les résultats indiquent que le réseau a atteint une plus grande précision dans les prédictions, ce qui implique en outre que la conception à la demande peut être résolue grâce à notre méthode. L'utilisation de l'apprentissage en profondeur pour guider la conception des métamatériaux peut automatiquement obtenir des structures de métamatériaux plus précises, un résultat inaccessible par les méthodes de conception traditionnelles.

Disponibilité des données et des matériaux

La date à laquelle le manuscrit provient de notre réseau de simulation, et nous ne pouvons pas le partager pour des raisons personnelles.

Abréviations

- ELU :

-

Unités linéaires exponentielles

- Couche FC :

-

Couche entièrement connectée

- Couche FE :

-

Couche d'extraction d'entités

- FNN :

-

Réseau de neurones de transfert

- MSE :

-

Erreurs quadratiques moyennes

- ReLU :

-

Unité linéaire rectifiée

- RNN :

-

Réseau de neurones inversé

- SRR :

-

Résonateur à anneau brisé

Nanomatériaux

- Tirer parti des FPGA pour l'apprentissage en profondeur

- Processeur automobile doté d'un accélérateur d'IA intégré

- Reconnaissance des chiffres AI avec PiCamera

- Un robot mobile avec un évitement d'obstacles basé sur la vision

- Amélioration des performances des actifs grâce à l'apprentissage automatique

- Apprentissage non supervisé avec des neurones artificiels

- WND s'associe à Sigfox pour fournir au Royaume-Uni un réseau IoT

- Méthode de chaîne Split () en Java :comment diviser une chaîne avec un exemple

- Prédire la durée de vie des batteries grâce à l'apprentissage automatique