Le rapport ETSI ouvre la voie à la standardisation de la sécurité de l'IA

Un nouveau rapport de l'ETSI, l'organisation européenne de normalisation pour les réseaux et services de télécommunications, de radiodiffusion et de communications électroniques, vise à ouvrir la voie à l'établissement d'une norme pour la sécurité de l'intelligence artificielle (IA).

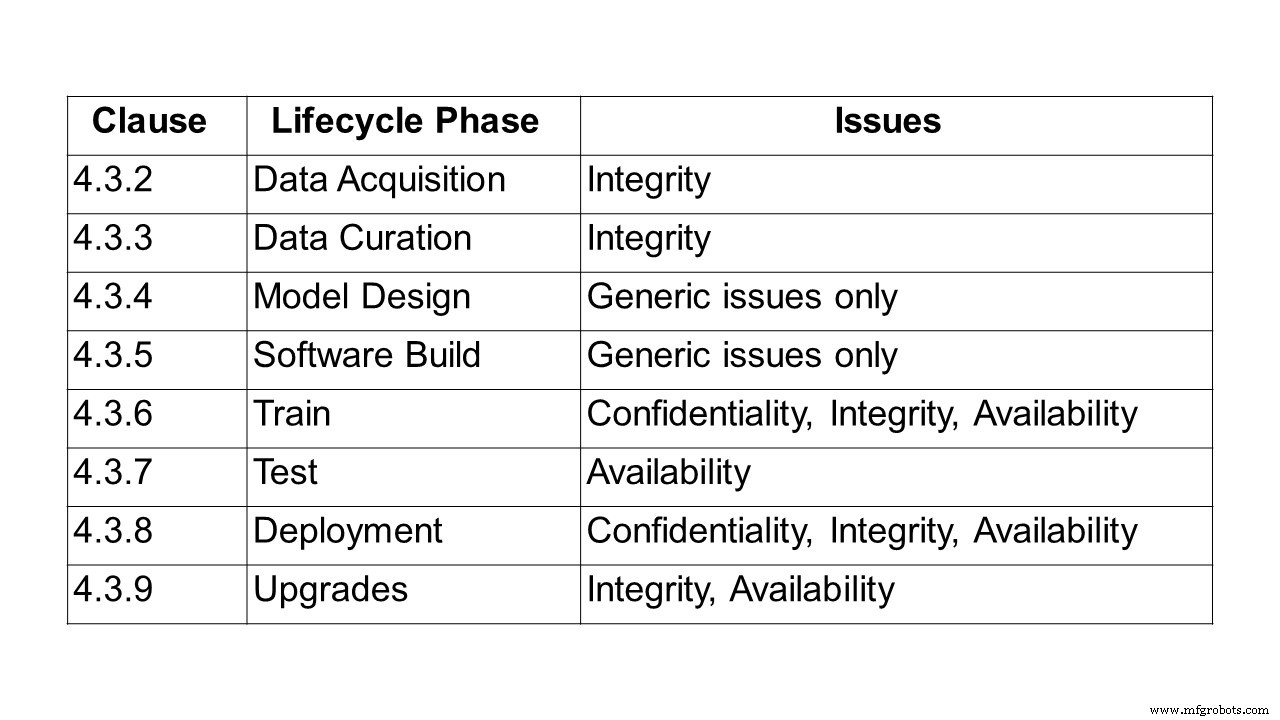

La première étape de la création d'une norme consiste à décrire le problème de la sécurisation des systèmes et des solutions basés sur l'IA. C'est ce que fait le rapport de 24 pages, ETSI GR SAI 004, le premier à être publié par l'ETSI Securing Artificial Intelligence Industry Specification Group (SAI ISG). Il définit l'énoncé du problème et met particulièrement l'accent sur l'apprentissage automatique (ML) et les défis liés à la confidentialité, à l'intégrité et à la disponibilité à chaque étape du cycle de vie de l'apprentissage automatique. Il souligne également certains des défis plus larges des systèmes d'IA, notamment les préjugés, l'éthique et la capacité à s'expliquer. Un certain nombre de vecteurs d'attaque différents sont décrits, ainsi que plusieurs cas d'utilisation et d'attaques dans le monde réel.

Pour identifier les enjeux liés à la sécurisation de l'IA, la première étape a été de définir l'IA. Pour le groupe ETSI, l'intelligence artificielle est la capacité d'un système à gérer des représentations, à la fois explicites et implicites, et des procédures à effectuer des tâches qui seraient considérées comme intelligentes si elles étaient exécutées par un humain. Cette définition représente encore un large spectre de possibilités. Cependant, un ensemble limité de technologies deviennent désormais réalisables, en grande partie grâce à l'évolution des techniques d'apprentissage automatique et d'apprentissage en profondeur, et à la grande disponibilité des données et de la puissance de traitement nécessaires pour former et mettre en œuvre ces technologies.

De nombreuses approches de l'apprentissage automatique sont couramment utilisées, y compris l'apprentissage supervisé, non supervisé, semi-supervisé et par renforcement.

- Apprentissage supervisé :toutes les données d'entraînement sont étiquetées et le modèle peut être entraîné pour prédire le résultat en fonction d'un nouvel ensemble d'entrées.

- Apprentissage semi-supervisé - où l'ensemble de données est partiellement étiqueté. Dans ce cas, même les données non étiquetées peuvent être utilisées pour améliorer la qualité du modèle.

- Apprentissage non supervisé :l'ensemble de données n'est pas étiqueté et le modèle recherche la structure des données, y compris le regroupement et le regroupement.

- Apprentissage par renforcement :une politique définissant la manière d'agir est apprise par les agents par le biais de l'expérience afin de maximiser leur récompense ; et les agents acquièrent de l'expérience en interagissant dans un environnement à travers des transitions d'état.

Au sein de ces paradigmes, diverses structures de modèles peuvent être utilisées, l'une des approches les plus courantes étant l'utilisation de réseaux de neurones profonds, où l'apprentissage est effectué sur une série de couches hiérarchiques qui imitent le comportement du cerveau humain.

Diverses techniques de formation peuvent également être utilisées, à savoir l'apprentissage contradictoire, où l'ensemble de formation contient non seulement des échantillons qui reflètent les résultats souhaités, mais également des échantillons contradictoires, qui sont destinés à contester ou à perturber le comportement attendu.

« Il y a beaucoup de discussions sur l'éthique de l'IA, mais aucune sur les normes relatives à la sécurisation de l'IA. Pourtant, ils deviennent essentiels pour assurer la sécurité des réseaux automatisés basés sur l'IA. Ce premier rapport ETSI vise à proposer une définition complète des défis rencontrés lors de la sécurisation de l'IA. En parallèle, nous travaillons sur une ontologie des menaces, sur la façon de sécuriser une chaîne d'approvisionnement de données d'IA et de la tester », explique Alex Leadbeater, président de l'ETSI SAI ISG.

Interrogé sur les délais, Leadbeater a déclaré à Embedded.com :« 12 mois supplémentaires est une estimation raisonnable des spécifications techniques. D'autres rapports techniques seront publiés au cours des deux prochains trimestres (AI Threat Ontology, Data Supply Chain Report, SAI Mitigation Strategy report). En fait, une spécification sur les tests de sécurité de l'IA devrait être publiée avant la fin du T2/T3. Les prochaines étapes consisteront à identifier des domaines spécifiques dans l'énoncé du problème qui peuvent être développés en éléments de travail informatifs plus détaillés. »

Plan du rapport

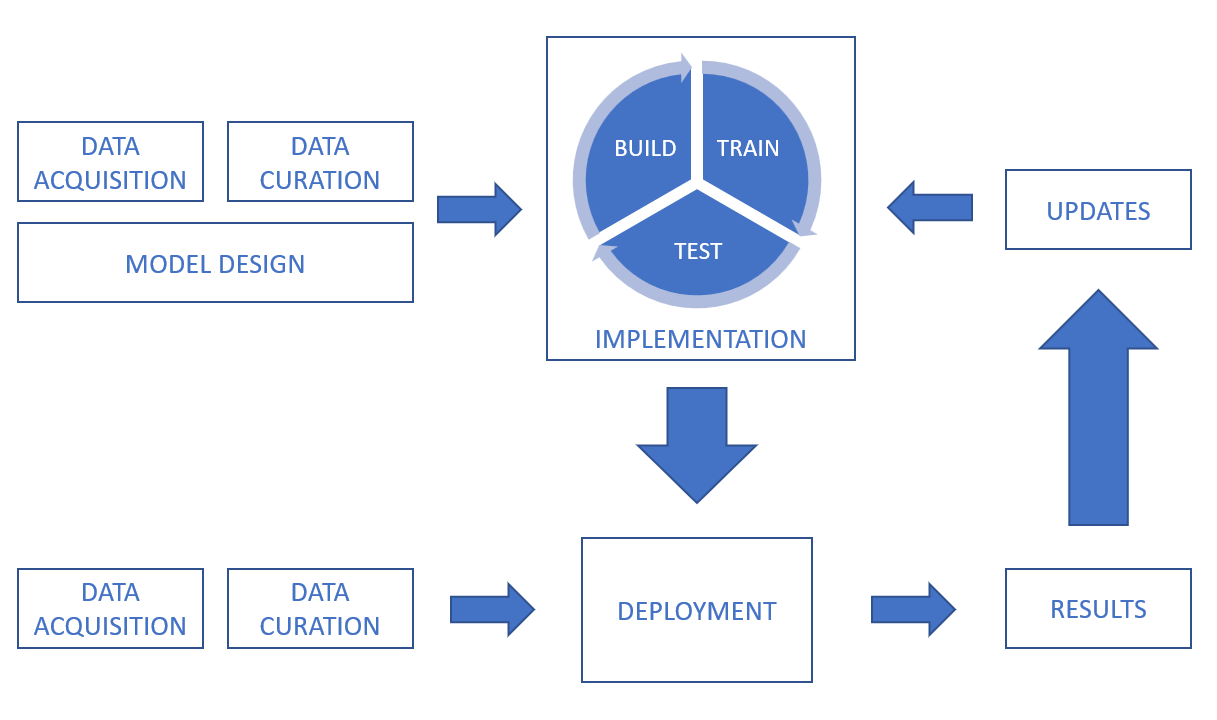

Après la définition de l'IA et de l'apprentissage automatique, le rapport examine ensuite la chaîne de traitement des données, couvrant les défis de confidentialité, d'intégrité et de disponibilité tout au long du cycle de vie, de l'acquisition de données, la conservation des données, la conception de modèles et la construction de logiciels, à la formation, les tests, le déploiement et inférence et mises à niveau.

Dans un système d'IA, les données peuvent être obtenues à partir d'une multitude de sources, y compris des capteurs (tels que des caméras de vidéosurveillance, des téléphones portables, des appareils médicaux) et des actifs numériques (tels que des données de plateformes de trading, des extraits de documents, des fichiers journaux). Les données peuvent également se présenter sous de nombreuses formes différentes (y compris du texte, des images, de la vidéo et de l'audio) et peuvent être structurées ou non structurées. En plus des défis de sécurité liés aux données elles-mêmes, il est important de considérer la sécurité de la transmission et du stockage.

Pour donner une indication des problèmes d'intégrité dans la conservation des données, lors de la réparation, de l'augmentation ou de la conversion des ensembles de données, il est important de s'assurer que les processus ne risquent pas d'avoir un impact sur la qualité et l'intégrité des données. Pour les systèmes d'apprentissage automatique supervisé, il est important que l'étiquetage des données soit précis et aussi complet que possible, et de s'assurer que l'étiquetage conserve son intégrité et ne soit pas compromis, par exemple par des attaques par empoisonnement. Il est également important de relever le défi de s'assurer que l'ensemble de données est impartial. Les techniques d'augmentation des données peuvent avoir un impact sur l'intégrité des données.

Un autre domaine couvert concerne les défis de conception, d'autres facteurs non intentionnels concernant les biais, l'éthique des données et l'explicabilité.

Par exemple, les biais doivent être pris en compte non seulement pendant les phases de conception et de formation, mais également après le déploiement d'un système, car des biais pourraient encore être introduits. Le rapport cite un exemple datant de 2016, lorsqu'un chatbot a été lancé, qui se voulait une expérience de « compréhension conversationnelle ». Le chatbot interagirait avec les utilisateurs des réseaux sociaux par le biais de tweets et de messages directs. En quelques heures, le chatbot commençait à tweeter des messages très offensants. Après le retrait du chatbot, il a été découvert que le compte du chatbot avait été manipulé pour afficher un comportement biaisé par les trolls Internet. Le biais ne représente pas nécessairement un problème de sécurité, mais peut simplement faire en sorte que le système ne réponde pas à ses exigences fonctionnelles.

En matière d'éthique, le rapport met en évidence plusieurs exemples, dont les voitures autonomes et les soins de santé. Il cite un article de l'Université de Brighton qui a discuté d'un scénario hypothétique dans lequel une voiture propulsée par l'IA renverse un piéton et a exploré les responsabilités légales qui en découlent. En mars 2018, ce scénario est devenu réalité lorsqu'une voiture autonome a heurté et tué un piéton dans la ville de Tempe, en Arizona. Cela a mis en évidence non seulement les responsabilités légales, mais les défis éthiques potentiels du processus décisionnel lui-même. En 2016, le Massachusetts Institute of Technology (MIT) a lancé un site Web appelé Moral Machine explorant les défis de permettre aux systèmes intelligents de prendre des décisions de nature éthique. Le site tente d'explorer comment les humains se comportent face à des dilemmes éthiques et de mieux comprendre comment les machines devraient se comporter.

Le rapport souligne que si les préoccupations éthiques n'ont pas d'incidence directe sur les caractéristiques de sécurité traditionnelles que sont la confidentialité, l'intégrité et la disponibilité, elles peuvent avoir un effet significatif sur la perception d'un individu quant à la fiabilité d'un système. Il est donc essentiel que les concepteurs et les responsables de la mise en œuvre des systèmes d'IA prennent en compte les défis éthiques et cherchent à créer des systèmes éthiques solides qui peuvent renforcer la confiance entre les utilisateurs.

Enfin, le rapport examine les types d'attaques, de l'empoisonnement et les attaques de porte dérobée à l'ingénierie inverse, suivis des cas d'utilisation et des attaques dans le monde réel.

Dans une attaque par empoisonnement, un attaquant cherche à compromettre le modèle d'IA, normalement pendant la phase d'entraînement, afin que le modèle déployé se comporte de la manière souhaitée par l'attaquant. Cela peut être dû à l'échec du modèle en fonction de certaines tâches ou entrées, ou au fait que le modèle apprend un ensemble de comportements qui sont souhaitables pour l'attaquant, mais non prévus par le concepteur du modèle. Les attaques d'empoisonnement peuvent généralement se produire de trois manières :

- Intoxication des données – dans lequel l'attaquant introduit des données incorrectes ou mal étiquetées dans l'ensemble de données pendant les phases de collecte ou de conservation des données.

- Empoisonnement des algorithmes – lorsqu'un attaquant interfère avec les algorithmes utilisés pour le processus d'apprentissage. Par exemple, l'apprentissage fédéré implique la formation de modèles individuels sur des sous-ensembles de données, puis la combinaison des modèles appris pour former le modèle final. Cela signifie que les ensembles de données individuels restent privés mais créent une vulnérabilité inhérente. Étant donné que tout ensemble de données individuel pourrait être contrôlé par un attaquant, celui-ci pourrait manipuler directement cette partie du modèle d'apprentissage et influencer l'apprentissage global du système.

- Empoisonnement modèle – lorsque l'ensemble du modèle déployé est simplement remplacé par un modèle alternatif. Ce type d'attaque est similaire à une cyberattaque traditionnelle où les fichiers électroniques composant le modèle pourraient être modifiés ou remplacés.

Alors que le terme « intelligence artificielle » est né lors d'une conférence dans les années 1950 au Dartmouth College de Hanover, New Hampshire, États-Unis, les cas d'utilisation réelle décrits dans le rapport de l'ETSI montrent à quel point il a évolué depuis. De tels cas incluent les attaques de bloqueurs de publicités, l'obscurcissement des logiciels malveillants, les deepfakes, la reproduction de l'écriture manuscrite, la voix humaine et les fausses conversations (qui ont déjà suscité de nombreux commentaires avec les chatbots).

Quelle est la prochaine étape ? Rapports en cours dans le cadre de cet ISG

Ce groupe de spécification de l'industrie (ISG) examine plusieurs rapports en cours dans le cadre des éléments de travail qu'il approfondira.

Tests de sécurité :Le but de cet élément de travail est d'identifier les objectifs, les méthodes et les techniques appropriés pour les tests de sécurité des composants basés sur l'IA. L'objectif global est d'avoir des directives pour les tests de sécurité de l'IA et des composants basés sur l'IA en tenant compte des différents algorithmes d'IA symbolique et sous-symbolique et en traitant les menaces pertinentes de l'élément de travail « ontologie des menaces de l'IA ». Les tests de sécurité de l'IA présentent certains points communs avec les tests de sécurité des systèmes traditionnels, mais présentent de nouveaux défis et nécessitent des approches différentes, en raison de

(a) des différences significatives entre l'IA symbolique et sous-symbolique et les systèmes traditionnels qui ont de fortes implications sur leur sécurité et sur la façon de tester leurs propriétés de sécurité ;

(b) le non-déterminisme puisque les systèmes basés sur l'IA peuvent évoluer avec le temps (systèmes d'auto-apprentissage) et les propriétés de sécurité peuvent se dégrader ;

(c) problème d'oracle de test, l'attribution d'un verdict de test est différente et plus difficile pour les systèmes basés sur l'IA car tous les résultats attendus ne sont pas connus a priori, et (d) algorithmes basés sur les données :contrairement aux systèmes traditionnels, les données (d'entraînement) forme le comportement de l'IA sous-symbolique.

La portée de cet élément de travail sur les tests de sécurité est de couvrir les sujets suivants (mais sans s'y limiter) :

- Approches de test de sécurité pour l'IA

- tester les données pour l'IA du point de vue de la sécurité

- Oracles de test de sécurité pour l'IA

- définition des critères d'adéquation des tests pour les tests de sécurité de l'IA

- tester les objectifs pour les attributs de sécurité de l'IA

Et il fournit des directives pour les tests de sécurité de l'IA en tenant compte des sujets mentionnés ci-dessus. Les directives utiliseront les résultats de l'élément de travail « Ontologie des menaces d'IA » pour couvrir les menaces pertinentes pour l'IA par le biais de tests de sécurité et aborderont également les défis et les limites lors du test d'un système basé sur l'IA.

ontologie des menaces d'IA :Le but de cet élément de travail est de définir ce qui serait considéré comme une menace d'IA et en quoi elle pourrait différer des menaces contre les systèmes traditionnels. Le point de départ qui justifie ce travail est qu'à l'heure actuelle, il n'y a pas de compréhension commune de ce qui constitue une attaque contre l'IA et de la manière dont elle peut être créée, hébergée et propagée. Le livrable de l'élément de travail « ontologie des menaces d'IA » cherchera à aligner la terminologie entre les différentes parties prenantes et plusieurs secteurs. Ce document définira ce que l'on entend par ces termes dans le contexte de la cybersécurité et de la sécurité physique et avec un récit d'accompagnement qui devrait être facilement accessible par les experts et les publics moins informés dans les multiples industries. Notez que cette ontologie de menace traitera de l'IA en tant que système, en tant qu'attaquant adverse et en tant que défenseur du système.

Rapport sur la chaîne d'approvisionnement des données :Les données sont un élément essentiel dans le développement des systèmes d'IA. Cela inclut des données brutes ainsi que des informations et des commentaires d'autres systèmes et d'humains dans la boucle, qui peuvent tous être utilisés pour modifier la fonction du système en formant et en recyclant l'IA. Cependant, l'accès à des données adaptées est souvent limité, ce qui oblige à recourir à des sources de données moins adaptées. Il a été démontré que compromettre l'intégrité des données d'entraînement est un vecteur d'attaque viable contre un système d'IA. Cela signifie que la sécurisation de la chaîne d'approvisionnement des données est une étape importante dans la sécurisation de l'IA. Ce rapport résumera les méthodes actuellement utilisées pour générer des données pour la formation de l'IA, ainsi que les réglementations, les normes et les protocoles qui peuvent contrôler le traitement et le partage de ces données. Il fournira ensuite une analyse des lacunes sur ces informations pour définir les exigences possibles des normes pour assurer la traçabilité et l'intégrité des données, les attributs associés, les informations et les commentaires, ainsi que la confidentialité de ceux-ci.

Stratégie d'atténuation des ISC rapport :cet élément de travail vise à résumer et à analyser les mesures d'atténuation existantes et potentielles contre les menaces pour les systèmes basés sur l'IA. L'objectif est d'avoir des directives pour atténuer les menaces introduites en adoptant l'IA dans les systèmes. Ces directives éclaireront les bases de la sécurisation des systèmes basés sur l'IA en atténuant les menaces de sécurité connues ou potentielles. Ils abordent également les capacités de sécurité, les défis et les limites lors de l'adoption de mesures d'atténuation pour les systèmes basés sur l'IA dans certains cas d'utilisation potentiels.

?Le rôle du matériel dans la sécurité de l'IA : Préparer un rapport qui identifie le rôle du matériel, à la fois spécialisé et à usage général, dans la sécurité de l'IA. Cela abordera les atténuations disponibles dans le matériel pour empêcher les attaques et répondra également aux exigences générales du matériel pour prendre en charge SAI. En outre, ce rapport abordera les stratégies possibles pour utiliser l'IA pour la protection du matériel. Le rapport fournira également un résumé de l'expérience universitaire et industrielle en matière de sécurité matérielle pour l'IA. En outre, le rapport abordera les vulnérabilités ou les faiblesses introduites par le matériel qui peuvent amplifier les vecteurs d'attaque sur l'IA.

Le rapport ETSI complet définissant l'énoncé du problème pour la sécurisation de l'IA est disponible ici.

Technologie de l'Internet des objets

- Conseils et tendances de sécurité IIoT pour 2020

- Une recette pour la sécurité industrielle :une pincée d'informatique, une pincée d'OT et une pincée de SOC

- La recherche d'une norme de sécurité IoT universelle

- TI :la technologie de résonateur BAW ouvre la voie aux communications de nouvelle génération

- Guide de cybersécurité publié pour les utilisateurs professionnels du cloud

- Un rapport appelle à une action urgente pour faire face aux cybermenaces contre les infrastructures critiques

- Trois étapes pour la sécurité globale de l'IoT

- Un guide en quatre étapes pour l'assurance de la sécurité des périphériques Iot

- Ce que l'arrivée de la 5G signifie pour la sécurité de l'IoT