Lutter contre les biais de formation dans l'apprentissage automatique

Enseigner à tout le monde ce qu'est « l'équité » est un objectif louable.

En tant qu'humains, nous ne sommes pas nécessairement d'accord sur ce qui est juste. Cela dépend parfois du contexte. Apprendre aux enfants à être justes, à la maison comme à l'école, est fondamental, mais c'est plus facile à dire qu'à faire. Dans cet esprit, comment pouvons-nous, en tant que société, communiquer les nuances « d'être juste » aux systèmes d'intelligence artificielle (IA) ?

Une équipe de chercheurs d'IBM Research fait la première partie de cette énigme. IBM déploie une boîte à outils pour les développeurs appelée « AI Fairness 360 ». Dans le cadre de cet effort, IBM propose aux entreprises un nouveau « service cloud, de détection des biais et d'atténuation » que les entreprises peuvent utiliser pour tester et vérifier le comportement des systèmes basés sur l'IA.

Dans une interview téléphonique avec EE Times, Saska Mojsilovic, membre d'IBM Research, nous a dit que les scientifiques et les praticiens de l'IA se sont beaucoup trop concentrés sur l'exactitude de l'IA. En règle générale, la première question que les gens se posent à propos de l'IA est :« Les machines peuvent-elles battre les humains ? »

Mais qu'en est-il de l'équité ? Le manque d'équité dans l'IA a le potentiel d'induire des conséquences catastrophiques dans, par exemple, les soins de santé ou les véhicules autonomes, a-t-elle déclaré.

Que se passe-t-il si un jeu de données utilisé pour entraîner une machine est biaisé ? Si l'IA ne peut pas expliquer comment elle a pris une décision, comment pourrions-nous vérifier sa « justice ? » L'IA peut-elle révéler si les données ont été manipulées d'une manière ou d'une autre pendant le traitement de l'IA ? L'IA pourrait-elle nous assurer que ses données n'ont jamais été attaquées ou compromises, y compris pendant le pré- et le post-traitement ?

Bref, existe-t-il une IA introspective ? La réponse simple :Non.

Sans être transparents pour les utilisateurs, les développeurs et les praticiens de l'IA, les systèmes d'IA ne peuvent pas gagner la confiance de la société, a déclaré Mojsilovic.

Décomposition de l'équité

Une question plus importante est de savoir comment enseigner à la machine ce qu'est l'équité. Mojsilovic a noté:"Parce que nous sommes des scientifiques, la première chose que nous avons faite a été de décomposer" l'équité ". Nous devions mettre la main dessus. " Ils ont brisé l'équité en termes de métriques, d'algorithmes et de biais pratiqués dans la mise en œuvre de l'IA.

Kush Varshney, chercheur scientifique chez IBM, a expliqué que l'équipe s'est penchée sur les biais et l'équité dans les algorithmes d'IA et la prise de décision en matière d'IA. « Il y a équité envers les individus et équité envers les groupes. Nous avons examiné différents attributs des groupes, allant du sexe à la race. Les questions juridiques et réglementaires sont également prises en compte. En fin de compte, l'équipe a fini par mesurer 30 métriques différentes pour rechercher des biais dans les ensembles de données, les modèles d'IA et les algorithmes.

Ces résultats sont intégrés dans la boîte à outils AI Fairness 360 qu'IBM a lancée cette semaine. La société l'a décrit comme "une boîte à outils open source complète de métriques pour vérifier les biais indésirables dans les ensembles de données et les modèles d'apprentissage automatique".

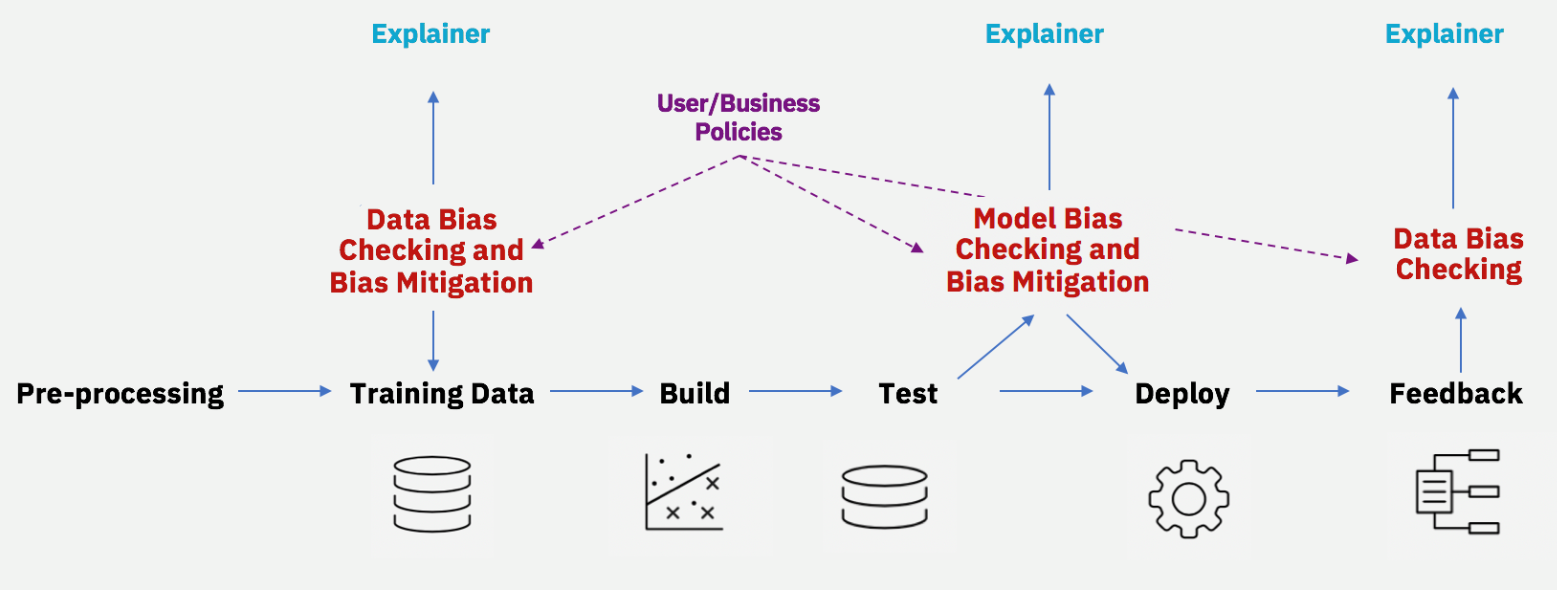

Atténuer les biais tout au long du cycle de vie de l'IA (Source :IBM)

Bien que de nombreux scientifiques s'efforcent déjà de détecter la discrimination dans les algorithmes d'IA, Mojsilovic a déclaré que l'approche d'IBM diffère en incluant des algorithmes non seulement pour trouver des biais, mais également un outil de débiaisage.

À un niveau de base, vous devez vous poser la question suivante :les informaticiens - définir l'équité ? C'est une tâche normalement assignée aux chercheurs en sciences sociales ? Conscient de cette incongruité, IBM a clairement indiqué que ni Mojsilovic ni Varshney ne travaillaient dans le vide. Ils ont fait venir une foule d'universitaires et d'instituts. Varshney a participé à la conférence sur l'éthique d'Uehiro-Carnegie-Oxford parrainée par le Carnegie Council for Ethics in International Affair. Mojsilovic a participé à un atelier d'IA à Berkeley, en Californie, parrainé par l'UC Berkeley Law School.

Un algorithme est-il neutre ?

Les sociologues ont signalé le problème des biais de l'IA depuis un certain temps.

Young Mie Kim, professeur à l'École de journalisme et de communication de masse de l'Université du Wisconsin à Madison, a expliqué :« La discrimination par l'IA (ou biais de l'IA) peut se produire lorsqu'elle renforce implicitement ou explicitement les ordres et les préjugés sociaux inégaux existants (par exemple, le sexe, la race, âge, statut social/économique, etc.). Les exemples vont des erreurs d'échantillonnage (p. Kim a fait valoir que le biais de l'IA existe même avec des "décisions stratégiques" dans la conception ou la modélisation, telles que les algorithmes de publicité politique.

Dans sa récente étude intitulée "Algorithmic Opportunity :Digital Advertising and Inequality of Political Involvement", Kim a démontré comment les inégalités peuvent être renforcées dans les décisions basées sur des algorithmes.

La communauté technique pourrait faire valoir qu'« un algorithme est neutre » ou qu'il peut être « éduqué » (formé). Kim a noté :« Cela ne reconnaît pas que les préjugés entrent à n'importe quel stade du développement de l'algorithme. »

Technologie de l'Internet des objets

- Apprentissage automatique sur AWS ; Tout savoir

- La chaîne d'approvisionnement et l'apprentissage automatique

- Optimisation de l'efficacité de la formation sur la fiabilité

- Mobius présente un logiciel de formation à l'équilibrage des machines

- NXP double l'apprentissage automatique à la périphérie

- Comment utiliser l'apprentissage automatique dans l'environnement d'entreprise d'aujourd'hui

- Apprentissage automatique sur le terrain

- S'attaquer à la courbe d'apprentissage PID

- Apprentissage automatique dans la maintenance prédictive